the-linux-programming-interface

Table of Contents

- Chapter 02: Fundamental Concepts

- The Core Operating System: The Kernel

- The Shell

- Users and Groups

- Single Directory Hierarchy, Directories, Links, and Files

- File I/O Model

- Programs

- Processes

- Memory Mappings

- Static and Shared Libraries

- Interprocess Communication and Synchronization

- Signals

- Threads

- Process Groups and Shell Job Control

- Sessions, Controlling Terminals, and Controlling Process

- Pseudoterminals

- Date and Time

- Client-Server Architecture

- Realtime

- The /proc File System

- Chapter 03: System programming concepts

- Chapter 04: File I/O: The Universal I/O Model

- Chapter 05: FILE I/O: Further Details

- Atomicity and Race Conditions

- File Control Operations: fcntl()

- Open File Status Flags

- Relationship Between File Descriptors and OpenFiles

- Duplicating File Descriptors

- File I/O at a Specified Offset: pread() and pwrite()

- Scatter-Gathr I/O: readv() and writev()

- Truncating a File: truncate() and ftruncate()

- Nonblocking I/O

- I/O on Large Files

- The /dev/fd Directory

- Creating Temporary Files

- Chapter 06: Processes

- Chapter 07: Memory Allocation

- Chapter 08: Users and groups

- Chapter 09: Process credentials

- Chapter 10: Time

- Chapter 11: System Limits and Options

- Chapter 12: System and Process Information

- Chapter 13: File I/O Buffering

- Chapter 14: File System

- Device Special Files(Devices)

- Disks and Partitions

- File Systems

- I-nodes

- The Virtual File System (VFS)

- Journaling File Systems

- Single Directory Hierarchy and Mount Point

- Mounting and Unmounting File Systems

- Advanced Mount Features

- A Virtual Memory File System: tmpfs

- Obtaining Information About a File System: statvfs()

- Chapter 15: File Attributes

- Chapter 16: Extended Attributes

- Chapter 17: Access Control Lists

- Chapter 18: Directories And Links

- Chpater 19: Monitoring File Events

- Chapter 20: Signals: Fundamental Concepts

- Chapter 21: Signals: Signal Handlers

- Chapter 22: Signals: Advanced Features

- Chapter 23: Timers and Sleeping

- Chapter 24: Process Creation

- Chapter 25: Process Termination

- Chapter 26: Monitoring Child Processes

- Chapter 27: Program Execution

- Chapter 28: Process Creation and program execution in more detail

- Chapter 29: Threads: Introduction

- Chapter 30: Threads: Thread Synchronization

- Chapter 31: Threads: Thready Safety and Per-Thread Storage

- Chapter 32: Threads: Thread Cancellation

- Chapter 33: Threads: Further Details

- Chapter 34: Process groups, sessions, and job control

- Chapter 35: Process priorities and scheduling

- Chapter 36: Process Resources

- Chapter 37: Daemons

- Chapter 38: Writing Secure privileged programs

- Chapter 39: Capabilities

- Chapter 40: Login Accounting

- Chapter 41: Funamentals of shared libraries

- Chapter 42: Advanced features of shared libraries

- Chapter 43: Interprocess communication overview

- Chapter 56: Sockets: Introduction

- Chapter 57: Sockets: Unix Domain

- Chapter 58: Sockets: Fundamentals of TCP/IP Networks

Chapter 02: Fundamental Concepts

The Core Operating System: The Kernel

- operating system通常来说有两种意思:

- 广义上来说,包括整个command-line解析器, GUI, 文件管理等等所有的软件

- 狭义上来说,就是管理和分配计算机资源(比如CPU, RAM, 设备等等)的系统

- 我们的Linux Kernel其实就是狭义上的os的意思.

- 裸机上面不安装os也是可以运行的,但是os的存在能够让计算机的使用更加简单,因为

os(也就是Linux Kernel)其实就是为计算机提供了一层管理有限资源的软件层.

Linux kernel通常是在/boot/vmlinuz,是一个压缩过的可执行文件,其意义是 virtual memory Linux Zipped binary

Task performed by the kernel

- 通常来说kernel的主要责任有如下:

- process scheduling: 现在的机器都是多核的,而Linux是preemptive

multitasking os, 换句话说就是Linux能够支持让不同的核运行不同的进程,而且

preemptive(抢占式)的意思是操作系统可以终止某个进程的运行

这也就把运行多久的权利抓在了kernel手里,而不是让process可以想运行多久就多久 - memory management: 内存也是一种稀缺资源,所以Kernel需要使用virtual memory

的方法让内存在不同process之间共享.所谓virtual memory有如下优点:

- process之间,process和kernel之间的内存是隔绝的,所以他们之间是无法共享 内存的

- process只有一部分"真正的存在于内存", 这样同等的内存能偶容纳更多的process (其实每个process都认为自己有4G内存空间,如果不是只有'一部分'存在于内存, 那么16G内存也才能放4个process). 因为内存里面同时能放的process数目多了, 这会提高CPU的利用率:因为CPU有更大的概率在内存里面找到一个process!

- provision of a file system: 为计算机提供文件系统,以使得文件可以增删改查

- creation and termination of process: kernel可以从"文件"中读取一个program 然后赋予这个文件resource(cpu, memory), 然后这个program就运行起来,变成一个 process了. 当process结束运行的时候,kernel也要收回process的资源.

- Access to devices: kernel会简化对设备的管理.也会裁定多个process对设备的 访问

- Networking: kernel还"代理"user process来进行传递和接受network message(packet) 的任务.

- Provision of a System call application programing interface (API): user process需要完成某种权限要求较高的的操作的时候,会要求kernel"代为效劳", 途 径就是system call API

- process scheduling: 现在的机器都是多核的,而Linux是preemptive

multitasking os, 换句话说就是Linux能够支持让不同的核运行不同的进程,而且

preemptive(抢占式)的意思是操作系统可以终止某个进程的运行

- 除了上面说的这些特性,Linux同时还是一个"多用户"的操作系统,也就是说,它为每一

个用户提供了"virtual private computer":

- 每个用户可以单独登陆

- 每个用户的操作相互不干扰

- 每个用户都可以运行自己的process,而相互不干扰的访问多个用户共同的资源: 设 备和网络

Kernel mode and user mode

- 现代的cpu技术都会支持CPU在两种模式下运行:

- user mode

- kernel mode

- 上述硬件结构上面的特点我们可以想象成是CPU上面有个开关:一开, cpu就进入kernel mode;一关,就进入user mode.这个开关的动作是使用hardware instruction完成的

- virtual memory系统为了适应cpu的硬件结构,把自己的全部内存空间分成了两种:

- user space

- kernel space

- cpu为kernel mode的时候,两个space都可以访问,cpu为user mode的时候, 只能访问

user space的内存地址,越界访问会导致hardware exception:

- Linux上面只有kernel code是运行于kernel mode的,所以它可以访问所有的4G(32 位情况下)内存

- 所有其他的进程都是运行于user mode的,所以只能访问前3G内存.

- 也就是说CPU自己会在自己内部设置一个status word来标示自己是在什么mode下运行,

而virtual memory系统也分别给自己的地址设置了哪些mode可以运行的限制,根据wiki

上的解释就是.

For example, a CPU may be operating in Ring 0 as indicated by a status word in the CPU itself, but every access to memory may additionally be validated against a separate ring number for the virtual-memory segment targeted by the access, and/or against a ring number for the physical page (if any) being targeted. This has been demonstrated with the PSP handheld system. From => https://en.wikipedia.org/wiki/CPU_modes

- 换句话说,由于Linux上面只有kernel code是在kernel mode运行的,所以其他任何程 序都不可能使用3G+的地址(32位)

- 这里我们想给大家区分一下kernel mode和root mode:

- kernel mode是一种CPU的构造所形成的mode

On Linux, only kernel code (including kernel modules) is running in kernel mode. Everything else is in user mode.

- root mode是Unix-like系统里面的管理员的概念,即便一个program code以管理员 的身份运行,它依然是运行在user mode的(需要system call和kernel进行通信)

- kernel mode是一种CPU的构造所形成的mode

Process versus kernel views of the system

- 如果对Linux的"kernel代理process进行有权限的操作"这个理念不了解的话,可能会

尝试从process-oriented的方式来理解Linux, 但是其实process能力很小:

- 一个运行的process不知道自己什么时候被抢夺cpu,不知道自己下次什么时候运行

- 对signal什么时候来到也不清楚

- process不知道自己是在"物理内存的哪里"或者是在swap里面.

- process不知道自己要访问的文件的位置,它只是知道它的名字而已

- process无法和其他process通信

- process无法创建新的process,甚至无法结束自己

- process无法和设备,比如输入输出打交道

- 相对的,如果你从Kernel的角度理解Linux的话:

- kernel可以决定process何时得到cpu,得到多久的cpu

- kernel维护复杂的数据结构,知道每个process实际存在的物理地址(或者swap)

- kernel维护复杂的数据结构,把process知道的名字转化为具体的物理地址

- 所有进程间的通信都是通过kernel

- kernel创建新的process,并结束老的process

- 和外界device的通信工作也是kernel来完成

- 后面我们会看到,我们会说"一个process可以创建另外一个process",或者"一个process 可以写入文件", 这里的可以是"可以请求kernel为其工作"的意思

The Shell

- shell是一种让用户来执行某个program的"特殊用途的program",由于登陆才能使用,也 叫login shell

- 某些系统中的shell是kernel的一部分,但是在Unix-like系统中shell是user process

- Unix-like系统中存在着非常多的shell:

- Bourne shell (sh): 最早的shell

- C shell (csh): 和sh不兼容, 仅提供了些新功能

- Korn shell (ksh): 引入了csh的新功能,并且和sh兼容!

- Bourne again shell (bash): GNU版本的Bourne shell, 最广泛应用,在很多系统中 sh其实就是bash的soft link

- shell不仅仅是用来和用户进行交互,而且其实是shell script的"解释器"

Users and Groups

- 一个系统中的user都是唯一的,但是可能属于不同的group

Users

- 每有一个user,就会在/etc/passwd里面由一行属于它,包括了如下的信息:

- login name

- User ID 也叫UID.

- Group ID: 也叫GID. 列出user所有group里面的第一个

- Home directory

- Login Shell

- 原来这个文件中还存有加密的密码,后来出于安全原因放入了另外一个只有root有权 限查看的文件/etc/shadow

Groups

- "人以群分", 在unix系统中,做同一件事情的,会加入同一个组,比如想要不使用sudo 就使用docker,那么就得加入docker group

- 历史上,unix-like系统曾经只允许一个用户在一个组,不过后来改变了这个策略改变了.

现在是某个用户只能属于一个"primary group", 也就是/etc/passwd里面的用户的第

一个group,可以使用group命令来看看你所有的group, 第一个列出的group就是primary

group

$ groups vagrant vagrant : vagrant adm cdrom sudo dip plugdev lpadmin sambashare docker

- 在/etc/group文件里面存储了所有的组信息, 包括:

- group name

- group id

- user list: 使用逗号隔开的用户名列表. (需要注意的是在/etc/passwd里面指明

了比如root的primary group是root, 那么在/etc/group里面group root列表里面

就不会再有用户root了)

~$ sudo cat /etc/passwd | grep root root:x:0:0:root:/root:/bin/bash $ sudo cat /etc/group | grep root root:x:0:

Superuser

- id 为0的user是超级用户root, 拥有一切权限.它可以访问一切的文件(不管文件的访 问权限是什么), 但我们说了root只是用户里面的最高权限, 它运行的program还是user mode process.

Single Directory Hierarchy, Directories, Links, and Files

- Linux是从root(/)开始的文件系统. 这个文件系统里面有很多的类型:

- File types: 也叫regular或者plain文件

- Directories and links:

- 文件夹其实就是link的一个集合.

- 所谓link其实就是文件名和"文件的位置"的组合. 一个"文件位置"可能有多个文件名

- "文件位置"也有可能是文件夹.

- 文件夹里面里面至少也有两个link: "."和".."

- Symbolic links:symbolic link是一种非常特殊的link:

- link里面的配置是"文件名" + "文件位置"

- symbolic link里面的配置是"文件名" + "文件位置" (而文件位置所在的硬盘空 间里面写了一个另外一个'文件名'), 这个后面的"文件名"就叫target

- device file

- pipe file

- socket file

Filenames

- 在Linux系统里面filename最长可以到255个character,但是取名还是有很多讲究:

- 文件名最好使用65-character set,也就是[-._a-zA-Z0-9].它们也叫portable filename character set

- 使用hyphen(-)作为文件名非常不好. 因为"-"很可能被认为是shell command里面 的option

Pathname

- 文件名分两种:

- absolute pathname: 以"/"开头

- relative pathname: 以"."或者".."或者当前文件夹里面的文件开头.

Current working directory

- current working directory是一个process的概念,每个process启动的时候都会从它 的parent process继承来了

- cwd可以使用cd更改

File ownership and permissions

- 每一个文件都有一个自己相应的user ID和group ID来表示自己的ownership

- 每一个文件的ownership分成三个类别:

- 文件的User ID的用户的'读写执行'

- 文件的Group ID里面所有用户的'读写执行'

- 所有其他用户的'读写执行'

- '读写执行'对于文件和文件夹的意义有所不同:

- 对文件来说:就是"读取", "写入", 把当前文件运行成process

- 对文件夹来说:就是"文件夹里面的内容可以列出", "可以往文件夹里面加文件", "可以访问文件夹里面的文件"

File I/O Model

- Unix-like系统中,有一个概念叫做"universality of I/O",也就是"一切皆文件",换句 话说,就是处理IO的system call (比如open(), read(), close())是适用于"所有文件" 的,包括directory文件, device 文件等

- 如果文件可以被random访问的话,就可以使用lseek(), 而不可以使用lseek()的文件类

型如下, lseek()会返回ESPIPE:

- pipe

- socket

- FIFO

- Unix-like系统的换行符为LF(linefeed),而windows文件系统的换行符是CR(carriage return) + LF

- Unix-like系统也没有EOF(end-of-file),而是以read()没有返回任何内容来判定文件 到头

File descriptors

- IO的system call打开文件以后返回的句柄叫做file descriptor,通常是一个非负整数.

- 一个process会从parent里面继承三个file descriptor:

- 值为0的 standard input

- 值为1的 standard output

- 值为2的 standard error

The stdio library

- C语言的stdio library正是包装了IO一系列的system call

Programs

- program通常以两种方式存在(script语言不再此列):

- source code: 人类可以理解的文本

- binary machine-language: 机器可以理解的格式

Filters

- 有那么一类的bash application,它们的任务是从stdin读取一些内容,经过"修饰"打

印到output, 它们叫做filter:

- cat

- grep

- tr

- sort

- wc

- sed

- awk

Command-line arguments

- c语言main里面的两个参数(argc, argv)就为了command line的参数准备的.

int main(int argc, char *argv[])

Processes

- 简单来说, process就是program的运行时状态.

- kernel运行一个program的步骤是:

- 把program导入virtual memory

- 为program的变量分配内存空间

- 建立一系列的bookkeeping data structure来记录process的信息, 比如:

- process ID

- termination status

- user ID

- group ID

- 从kernel的角度上来讲, process是要和kernel一起共享计算机资源的.对于内存这种 资源, kernel是一开始分配一小块,然后随着process的要求和整个系统的能力,再进行 分配.

Process memory layout

- 一个process在逻辑上被分成如下的segment:

- Text: 二进制代码

- Data: program使用的static variable

- Heap: program可以用来动态申请内存的位置

- Stack: 用来存放local variable和 function call的位置

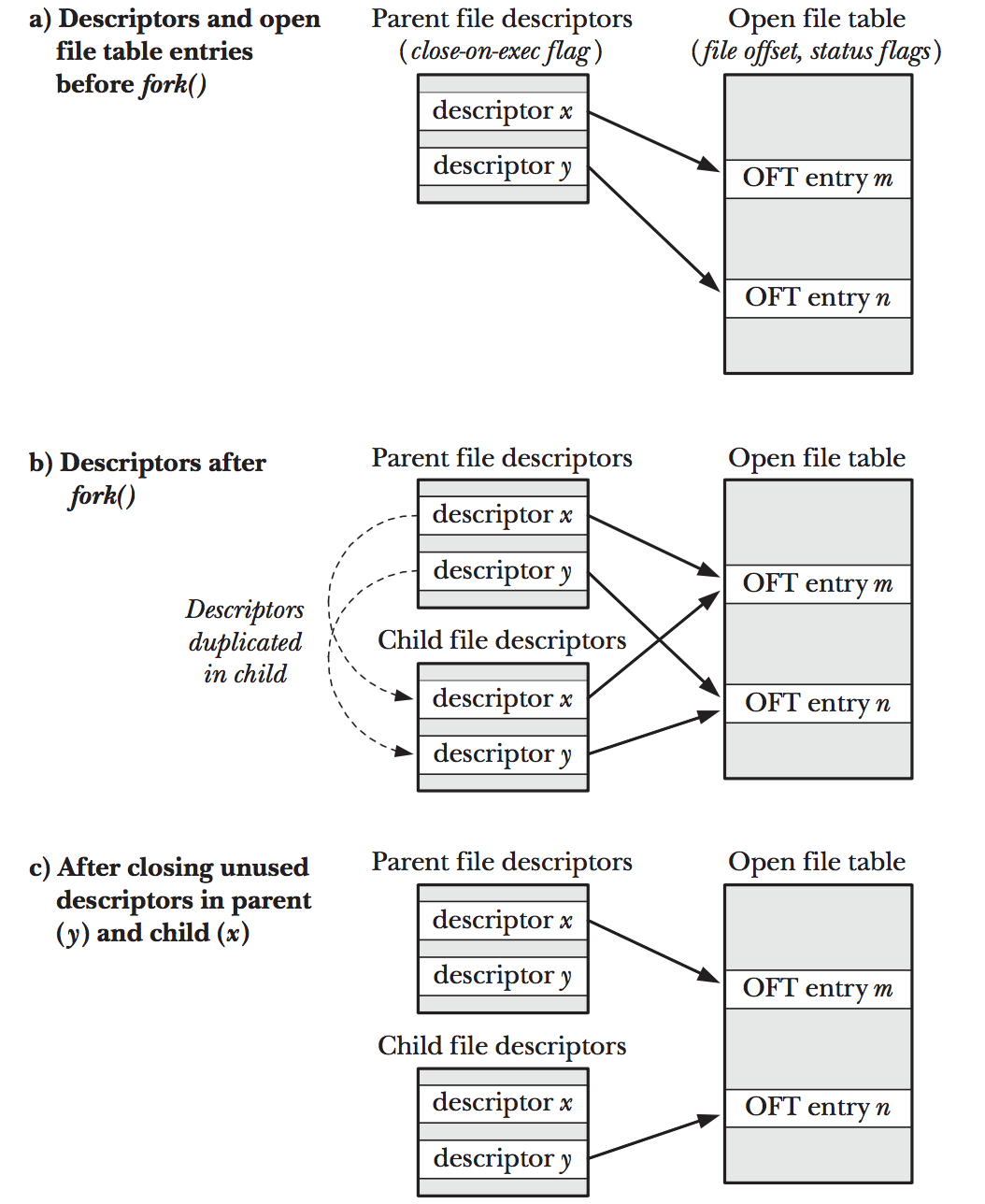

Process creation and program exectuion

- 一个process肯定是由另外的process 调用system call fork()产生出来的:

- 调用fork()的process叫做parent process

- 新产生的process叫做child process

- kernel创建child process的办法,是复制parent process的如下字段:

- Data

- Heap

- Stack

- 而Text segment因为是只读的,所以只是"reference"一个地址让parent和child共享. 当然,child process也可能会"写入"这个"reference的地址",一旦写入就会再新的地 方创建Text Segment

- 而作为child process,它的选择有两个:

- 在继承来的四个segment的基础上,运行一些不同的function

- 更常见的做法,是调用execve()系列system call来破坏已有的四个segments,创建 新的四个segments

Process ID and parent process ID

- 每个process都有PID来标示自己, PPID来标示自己的parent process

Process termination and termination status

- process可以在两种情况下结束:

- 自己了断自己的: 通过exit()系列system call,然后会exit()会发送termination status

- 被signal中断: 也会根据signal的不同来设定termination status

- 一般来讲, termination status 为0表明程序正常结束. 其他值都不是正常结束

- 在命令行运行完process后,可以使用$?来取得上次运行process的termination status

vagrant@vagrant:~$ ls dot-files shell-files tmp vagrant@vagrant:~$ echo $? 0

Process associated User ID

- 一个process有如下三个类别的User ID:

- Real user ID: 某个program是被哪个User调用然后变成process然后运行的

- Effective user ID: 某个process拥有和effective User ID一样的权限, 通常情

况下, Effective user ID和Real user ID是相同的, 但是也会有特殊的情况:

hfeng@vagrant:/home/vagrant/tmp$ ls -al total 60 drwxrwxr-x 4 vagrant vagrant 4096 Jul 15 06:56 . drwxr-xr-x 7 vagrant vagrant 4096 Jul 2 07:16 .. -rwxrwxr-x 1 vagrant vagrant 8504 Jul 15 06:56 a.out vagrant@vagrant:~$ ps -eo ruser,euser,suser,comm | grep a.out hfeng hfeng hfeng a.out

- 某个process可能是被root启动的,所有Real User ID和Effective User ID都是 0, 也就是说它有"全部的权限", 也就可以更改自己的Real User ID为任意值.那 么两者就不一样了

- 某个process可能是被普通的用户启动的,但是可能拥有"不普通"用户的权限,

达到这种效果的办法是set-UID, 一旦设置了这个"域",如果某个二进制program

属于高权限用户A,那么无论使用哪个低权限用户B,都可以让这个process把高权

限用户A作为自己的Effective user ID(注意a.out的权限-rwsrwxr-x).

vagrant@vagrant:~/tmp$ chmod u+s a.out vagrant@vagrant:~/tmp$ ls -al total 60 drwxrwxr-x 4 vagrant vagrant 4096 Jul 15 06:56 . drwxr-xr-x 7 vagrant vagrant 4096 Jul 2 07:16 .. -rwsrwxr-x 1 vagrant vagrant 8504 Jul 15 06:56 a.out vagrant@vagrant:~/tmp$ su hfeng Password: hfeng@vagrant:/home/vagrant/tmp$ ./a.out vagrant@vagrant:~$ ps -eo ruser,euser,suser,comm | grep a.out hfeng vagrant vagrant a.out

- Saved UID: Saved UID是专门为set-UID设计的,原因如下:

- 如果一个属于root的program设置了set-UID,那么以其他用户hfeng启动这个

process的话,saved uid不是和real uid一样了,而是和effective uid一样了

root@vagrant:~$ ps -eo ruser,euser,suser,comm | grep a.out hfeng root root a.out

- 之所以这么设置是基于两点:

- 有时候会放弃高权限用户root权限,转到低权限用户hfeng权限. (如果是root 的话,可以转到任何其他用户权限)

- 但当我们从低权限的hfeng再想"直接"转到root的话,是不可能的.所以我们保 留了一个saved uid位置来记录之前"牛逼"的权限,让process可以从"低权限" 更改到"高权限"

- 如果一个属于root的program设置了set-UID,那么以其他用户hfeng启动这个

process的话,saved uid不是和real uid一样了,而是和effective uid一样了

- 一个process的Group ID也分三类:

- Real group ID: real user 所在的primary group

- Effective group ID: effective user 所在的primary group

- Supplementary group IDs: 从parent继承的"补充型"group

- 执行命令的用户为root,或者root拥有的program被设置了set-UID后被执行,都会产生 privileged process.所有其他process都是unprivileged process

Capabilities

- 从Linux 2.2开始,权限被详细的分成了很多类别. 某个process想要做什么样的事情, 必须拥有这个类别的权限. privileged process可以认为是拥有所有权限类别的进程.

The init process

- init process是所有process的parent(或者grand parnt).其program所在的位置是/sbin/init

- init的PID是1, 拥有superuser privilege

- init process只有在关机的时候才能被kill

- init 的主要责任是创建和监管一个running system所必须的一系列程序

- init 只是拥有privileged权限的process,它并不是kernel code.

Daemon processes

- 有一类process叫daemon process, 它们有如下特征:

- long-lived, 通常情况下,开机就启动,知道系统关机

- 在后台运行, 并且没有响应的controlling terminal来读取和写入

- 这样的process有Linux系统自带的, 也有非系统自带的:

- 系统自带

- 非系统自带

Environment list

- 每一个process都有一个environment list,里面是数个environment variable的列表

- 一个process会从它的parent里面继承environment variable的一份拷贝.这也看做是 parent和child通信的一种手段.

- exec()系列system call可以设置参数覆盖原来的environment variable,也可以不覆 盖继续使用原来的.

Resource limits

- 每个process都会消耗一定的资源,比如:

- open files

- memory

- CPU time

- 每个process都有两个数值来确定它们的limit:

- soft limit: 每个process能够拥有的资源量

- hard limit: 每个非privileged process的soft limit可以更改,但是上限是hard limit

Memory Mappings

- mmap() system call是创建新的msmory mapping到调用process的virtual address space

里面去的函数, 这种mapping有两种情况:

- file mapping: 就是把一个文件mapping到virtual address space

- anonymous mapping: 没有对应文件,只不过是创建内容为0的内存page而已

Static and Shared Libraries

- 所谓object library是一个含所有compiled object code(通常是一些代码会调用的函

数)的文件.现代操作系统都有两种object library:

- static library:

- 早期的object library都是static的. 使用static library的program最终会把 static library里面的响应代码编译到自己的binary里面

- 每个process都存一份static library到自己的binary里面是非常浪费硬盘空间, 而且会浪费内存空间:特别是多个process都调用了同一份static library代码,它 们都会要求一份内存地址.那么内存里面就由多份一样的代码.

- 如果library function做了更改,那么所有想使用最新版本library的程序都要重 新编译.

- shared library:

- 和static library不同的是, shared library会在编译的时候在executable里面 标明位置,而不会拷贝这段代码

- 在runtime,只要有一份library的代码运行,那么用到它的process都可以share, 这儿是shared名字的来历.

- 这样一来library升级的时候,使用这些library的代码也不需要进行重新编译.

- static library:

Interprocess Communication and Synchronization

- process有时候需要和其他的process进行配合,从而达到运行目的.最简单能达到"交流" 的方法是通过一个文件,但是这种方法太慢,也不方便.

- 所以,Linux发明了如下丰富的IPC(interprocess communication)手段:

- signals: 声明某件事情出现

- pipes(对shell用户来说,就是'|') and FIFO: 用处就是在process直接传递data

- sockets: 可以跨机器,在process直接传递data

- file locking: 允许process锁住文件的一部分,防止其他process更改

- message queues: 在process之间交换数据

- semaphores: 是用来"同步"多个process操作的

- shared memory: 让多个process共享一块内存空间.当一个process更改这个内存空间 内容的时候,其他process也都能看到

Signals

- Signal一般被称作"software interrupts"和硬件发出的"hardware interrupt"相对应.

- Signal可以由kernel, 其他process,或者本process发出.

Threads

- 在Linux里面共享资源的process就是thread.

Process Groups and Shell Job Control

- shell上的每一个命令都是启动一个新的process

- 主流的shell都提供了一个叫做job control的功能,用来让用户在一个shell里面允许 多个process运行. 这个命令叫做jobs

- jobs控制的当然是job, 在bash的概念里面. 运行在一个pipeline里面的命令是一个

process group(也叫job), 这个pipe里面第一个运行的process就是这个group的lead,

而groupId也是以这个process的PID来命名的. 比如下面的这个例子中, python和more

属于一个process group(job).它们的group id就是pipe里面先运行的python的id(1501).

vagrant@vagrant:~$ python test.py | more& [1] 1502 vagrant@vagrant:~$ jobs [1]+ Running python test.py | more & vagrant@vagrant:~$ ps -eo pid,pgid,comm PID PGID COMMAND 1501 1501 python 1502 1501 more 1503 1503 ps

- 如果没有使用pipe的话,这个process自己组成一个process group.成员是它自己(1507).

vagrant@vagrant:~$ python test.py& [2] 1506 vagrant@vagrant:~$ 1506 1506 vagrant@vagrant:~$ jobs [1]- Running python test.py | more & [2]+ Running python test.py & vagrant@vagrant:~$ ps -eo pid,pgid,comm PID PGID COMMAND 1501 1501 python 1502 1501 more 1506 1506 python 1507 1507 ps

- 需要说明一下的是[+]是最新运行的process, [-]是仅仅跟随[+]process的下一个运行 的process.

- 把一个process转到前台运行办法是fg %[num], 再放到后台是Ctrl+z

vagrant@vagrant:~$ jobs [1]+ Running python test.py & vagrant@vagrant:~$ fg %1 python test.py ^Z [1]+ Stopped python test.py

- 而Ctrl+z之后这个job就会变成Stopped的状态.而让一个后台stopped的proces在后台

running的办法就是bg %[num]

vagrant@vagrant:~$ jobs [1]+ Stopped python test.py vagrant@vagrant:~$ bg %1 [1]+ python test.py & vagrant@vagrant:~$ jobs [1]+ Running python test.py &

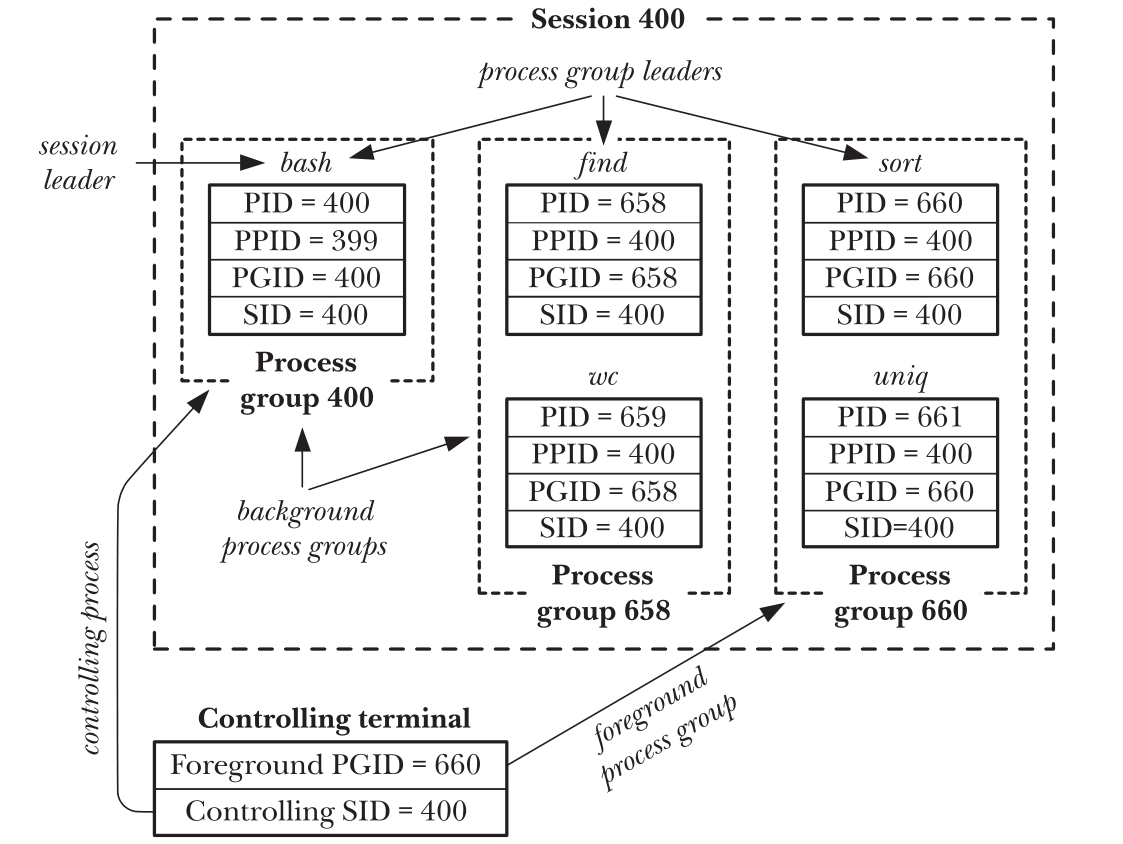

Sessions, Controlling Terminals, and Controlling Process

- session是一组process group(job)的组合.session leader是创建这个session的PID,

而这个leader的PID就成了session group的ID,所有的process group都属于创建它的

shell所在的session

vagrant@vagrant:~$ ps -eo pid,pgid,sid,comm PID PGID SID COMMAND 1487 1487 1487 bash 1510 0 0 kworker/0:0 1514 1514 1487 python 1516 1516 1487 ps

Pseudoterminals

- pseudoterminals在Linux中可以应用到X windows的terminal,或者是ssh创建的terminal

- 每当你创建一个pseudoterminal,就会在/dev/pts里面创建一个文件.比如我们有两个ssh

连接到vagrant虚拟机的时候,都会增加一个新的文件.比如我们有两个ssh连接到vagrant

vagrant@vagrant:~$ ls /dev/pts 0 1 ptmx

Date and Time

- 对于process来说,两种时间对它来说比较感兴趣:

- real time:在Unix-like系统中,就是计算从1970年1月1号开始的秒数.当然这个秒数 是根据你的时区不同而不同的.之所以选择这个时间,是因为这个是Unix系统诞生附近 的日子

- process time: 也叫CPU time,就是一个process从开始运行后使用的CPU时间,分成

两个部分:

- system CPU time: 就是kernel 为process工作的cpu时间

- user CPU time: 用户自己执行使用的cpu时间

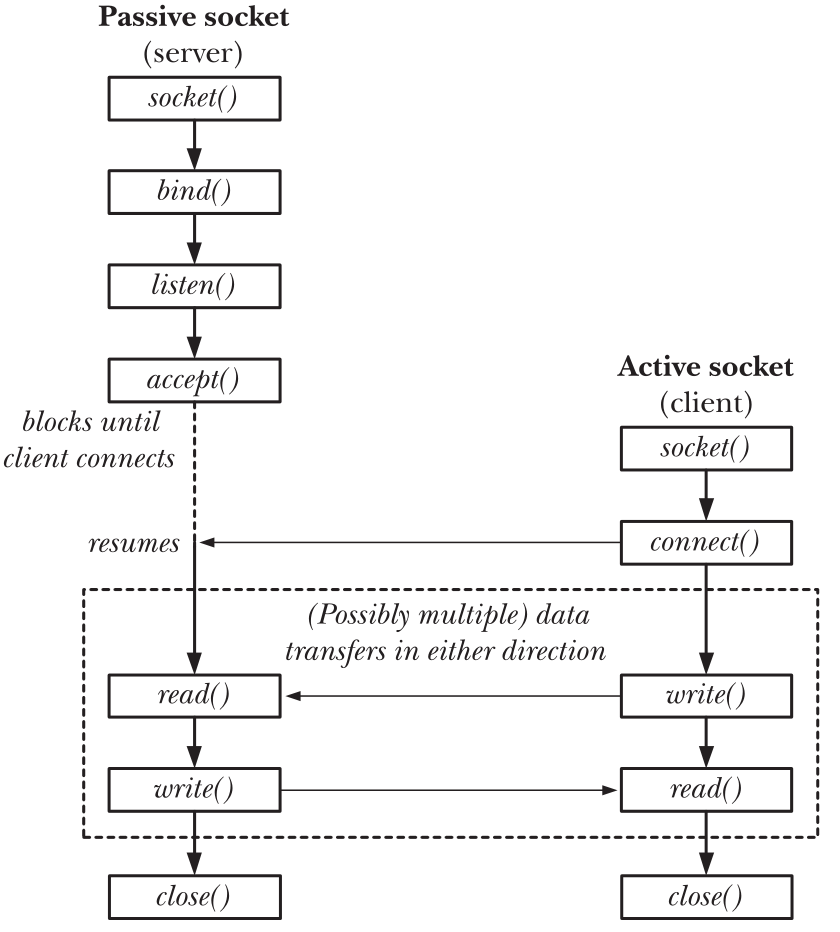

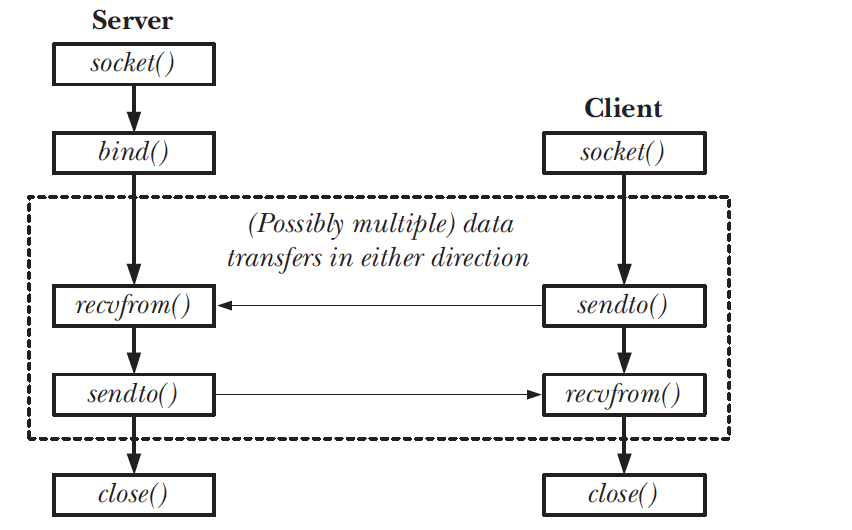

Client-Server Architecture

- 通常来说client来和用户交流,而server负责提供服务

Realtime

- 注意和前面的real time(有空格)相区别

- realtime是指某种设备:这种设备对输入之后的反应时间有具体要求:一定要在某个时间 内对input做出反馈.

The /proc File System

- 和其他Unix系统一样, Linux提供了一个虚拟的文件系统/proc

- /proc里面其实是一些文件,这些文件里面包含了kernel的数据结构(当然也就包括process 的).

- 我们来看一个例子,某个process的很多内容可以在/proc/[pid-num]文件夹下看到

vagrant@vagrant:/proc$ jobs -l [1]+ 2004 Running python ~/test.py & vagrant@vagrant:/proc$ cat /proc/2004/comm python vagrant@vagrant:/proc$ cat /proc/2004/cmdline python/home/vagrant/test.py vagrant@vagrant:/proc$ ls /proc/2004/ attr/ coredump_filter gid_map mountinfo oom_score schedstat status autogroup cpuset io mounts oom_score_adj sessionid syscall auxv cwd/ limits mountstats pagemap setgroups task/ cgroup environ loginuid net/ personality smaps timers clear_refs exe map_files/ ns/ projid_map stack uid_map cmdline fd/ maps numa_maps root/ stat wchan comm fdinfo/ mem oom_adj sched statm

- 很多配置的bash命令其实就是读取和写入这里的值

Chapter 03: System programming concepts

System Calls

- system call 是一些由kernel控制的entry point, 普通的process可以通过它们来让

kernel为自己完成一些高权限的任务,比如:

- 创建新的process

- 访问IO

- 创建PIPE

- system call有如下"常识":

- system call会更改processor的state, 从user mode => kernel mode, 这样一来CPU 才能访问protected kernel memory(就是读取这些地址的数据到processor里面)

- system call的数目固定,每个system call都被分配了一个数字

- 每个system call都有一系列为这次操作准备的argument

- 从编程的角度上来看, system call看起来像是调用了c语言的一个函数,但是其实从内

部来讲,system call做了很多工作(下面以x86-32为例):

- application应用想调用system call,都是通过调用c语言写成的包裹system call的 所谓"wrapper function"

- 我们调用wrapper function的时候,是将argument通过stack压栈传入的,但是system call使用这些参赛的时候,是希望它们在相应的寄存器里面的.所以wrapper就负责将 参赛从stack拷贝到相应的寄存器.

- 对于kernel来说,system call的不同体现在它们的"ID",也就是system call number 不一样,而触发的方式一样.所以wrapper负责把system call number写入到%eax里面 然后"触发"system call

- 这个"触发"就是machine instruction(int 0x80, int是intrrupt的缩写,是一个机

器语言语句),这其实是一个软件中断(software interrupt), 中断分两种:

- 硬件中断(hardware interrupt)是一种在任意时刻都可能发生的事情,比如我们 从键盘输入数据给计算机. 计算机是无法判断这些中断是什么时候来的

- 软件中断(software interrupt)其实是计算机"自己发给自己"的中断. 其实就是 一种"逃避"的手段,比如上一条指令是中断的话,下一条指令就没法执行了,因为 遇到了中断,当前的环境处理不了.要"跳"到另外的地方去执行,这个"跳到其他地方" 其实就是system call想要的.因为代码再其他地方

- 在"跳到其他地方执行"的同时,也会进行如下操作.

- 将cpu从user mode转化成kernel mode

- 执行system trap vector里面0x80处的代码. (换个角度讲, Linux只不过选择了 x80作为system call的exception 入口地址, 其实完全可以写成int 0x90, 然后 初始化system trap vector的时候,在x90处布置相应的handler)

- 这个system trap vector是在机器初始化的时候被填满的, 在vector的第128(0x80)

的位置,填的正是system_call()的代码地址, system_call主要做的工作是:

- 将cpu当前寄存器的值都存入到kernel stack

- 检查system call number(也就是存到%eax里面的,区别不同system call的序列 号)是否合法

- 根据system call number的不同,查阅sys_call_table后调用相应的routine.然后 调用相应的routine.

- 把routine返回的返回值写入到stack,并且"恢复"刚才保存的所有的cpu原来的寄 存器值

- 通过和int相对应的机器语句iret, 返回wrapper function,同时cpu从kernel mode 变回user mode

- 通常来说,system call routine在出现错误的时候,会返回负数,比如-6. 而wrapper 作为c libray,只是会设置返回值为-1来表示失败(0表示成功),失败的原因则是把system call routine的负数取正,写入到errno里面.

- 上面的这一系列讨论,其实暗示了我们,system call其实在调用的时候,是有一定的 性能损耗的.比如调用1千万次的c语言函数返回integer需要0.11秒,而调用system call getppid()1千万次则需要2.2秒!

- 因为wrapper function(内部调用system call)和对应的system call在c语言看来其实 是一回事,当然wrapper function看起来更c语言,而system call则可能是汇编语言.我 们后面一旦说到system call,其实是说的wrapper function that calls system call!

Library Functions

- library Function是专指standard C library中的一部分函数,这些函数分两类:

- 内部不调用system call(也就是system call wrapper)的,比如字符串相关函数

- 内部调用system call(也就是system call wrapper),但是比system call来的更易 于使用(more caller-friendly)比如malloc()和free()就比system call brk()好用

The Standard C Library; The GNU C Library(glibc)

- 不同的Unix都有自己的standard C library,在Linux上面的版本是GNU C Library

- 我们可以使用ldd命令来处理一个"动态库"的executable文件,就会得到executable使用

的动态库(glibc)的位置

$ ldd a.out linux-vdso.so.1 => (0x00007fffc9547000) libc.so.6 => /lib/x86_64-linux-gnu/libc.so.6 (0x00007f7e8d6f0000) /lib64/ld-linux-x86-64.so.2 (0x00007f7e8dac4000) - 而取得glibc版本的手段则是使用如下函数(能够判断runtime available的glibc版本)

#include <gnu/libc-version.h> const char *gnu_get_libc_version(void); /************************************************************/ /* Returns pointer to null-terminated, statically allocated */ /* string containing GNU C library version number */ /************************************************************/

Handling Errors from System Calls and Library Function

- system call 和library function都会返回statu value来表明自己是否出现了问题, 要记得时刻检查这个返回值,很多错误都是从这里发生的.

System Call Wrapper

- 对于system call wrapper函数来说,除了返回值是-1外,还会给errno这个全局变量设置 一个值(通过前面的介绍我们知道,其实是system call返回-N, 然后wrapper把-1返回 然后把N赋值给errno)

- <errno.h>头文件里面声明了以E开头的这些错误

cnt = read(fd, buf, numbytes); if (cnt == -1) { if (errno = EINTR) { fprintf(stderr, "read was interrupted by a signal\n"); } }

- 成功的system call wrapper函数不会去将errno重置为0,所以一定要再返回值为-1的 时候errno的值才有意义.

- 有时候也会手动先设置errno为0:因为有些函数是-1表示成功(比如getpriority(), 其 优先级就是-1),这个时候通过先设置errno为0,然后再遇到返回值"碰巧"为-1的时候, 通过errno来辨别这个-1是表示"失败"还是一个"有意义的值"(比如优先级为-1)

- 打印错误信息可用perror()和strerror()两个函数

Library Function

- 对于library function来说,情况和system call wrapper稍有不同,可以分成三类:

- -1表示失败, errno写入原因: 这种library function多数是内部调用system call wrapper,所以其错误处理的方法也就是学习了system call wrapper

- 其他表示失败的方式, errno写入原因: 这种肯定也是内部使用了system call wrapper, 所以才能有errno,但是决定不使用-1来表示错误,比如fopen返回NULL表 示失败.

- 其他表示失败的方式,也不写入errno:这种通常没有使用system call wrapper,对 这种函数使用perror()或者strerror()来打印错误是不对的.

Notes on the Example Programs in This Book

- 通常来说传统的Unix都是使用一个'-'加一个字母的方式来表示参数

- GNU提供了新的一种方式就是一个'–'加一个单词的方式

- 我们通过getopt() library function来读取参数

TODO

Chapter 04: File I/O: The Universal I/O Model

Overview

- 所有I/O操作的system call都会使用一个比较小的正整数做为file descriptor. 打开 所有类型的文件都会返回这个file descriptor

- 而每个program在运行之前,都会在shell的帮助下自动打开三个文件(也就用了0,1,2三

个file descriptor). 子所以说是shell的帮助,是因为在shell启动的process,其parent

就是shell,shell一直开着这三个文件, process一启动也就继承了这三个文件

File descriptor Purpose POSIX name stdio stream 0 standard input STDIN_FILENO stdin 1 standard output STDOUT_FILENO stdout 2 standard error STDERR_FILENO stderr - 需要注意的是,fd 0, 1, 2并不是总是对应这三个文件的,如果使用了freopen()的话,可 能某个文件的fd会改变.

- 下面是最常见的跟文件相关的system call, 但是日常使用通常是使用"内部调用这些

system call"的library function:

- fd = open(pathname, flags, mode): 打开(没有的情况下也有可能创建)一个文件

- numread = read(fd, buffer, count): 最多读取count数目的内容到buffer,真正读 取的数目写入numread

- numwritten = write(fd, buffer, count): 和读取相反的写入操作

- status = close(fd): 和打开相反的关闭操作.

Universality of I/O

- Unix所谓"一切皆文件"的特性就是说,open(), read(), write(), close()四个system call可以作用于所有类型的文件,比如device.

Changing the File Offset: lseek()

- 文件打开的时候,kernel会记录一个叫做file offset的变量,其实就是记录文件读取到

哪里了.

#include <unistd.h> off_t lseek(int fd, off_t offset, int whence); /* Returns new file offset if successful, or –1 on error */

- 参数如下:

- fd是文件描述符

- offset是从whence开始的距离

- whence有三种值:

- SEEK_SET: 从文件头开始

- SEEK_CUR: 从刚才的kernel记录的offset开始

- SEEK_END: 从文件末尾开始

- lseek()并不是对所有文件都可以,如下文件不支持"随机读取",也就不能使用lseek():

- FIFO

- pipe

- socket

- terminal

TODO

Chapter 05: FILE I/O: Further Details

Atomicity and Race Conditions

- 所有的system call都是"原子操作",换句话说kernel保证system call所有的step看起 来就像是一个step一样,不可分割.也不会被其他process所interrupt

- system call的原子性并不能保证使用这些system call的用户也能无所顾忌的写出没有 race condition的代码.因为两次system call调用之间还是可能产生"进程调度",也就 存在了race condition的可能.

File Control Operations: fcntl()

- fcntl() system call 主要用来对已打开的文件描述符进行权限操作

#include <fcntl.h> int fcntl(int fd, int cmd, ...); /* Return on success depends on cmd, or –1 on error */

- cmd argument确定是什么操作

- …是可选参数,根据cmd的不同而不同

Open File Status Flags

- fcntl()的一个主要作用是"读取"和"更改"一个open file的:

- access mode

- status flag

- 读取的方法是把cmd设为F_GETFL

int flags, accessMode; flags = fcntl(fd, F_GETFL); if (flags == -1) errExit("fcntl");

- 如果我们想测试这个文件是不是设置了O_SYNC(保证在写入硬盘以前不返回)

if (flags & O_SYNC) printf("writes are synchronized\n");

- 读取access mode稍微麻烦一点:需要先和flags相与

accessMode = flags & O_ACCMODE; if (accessMode == O_WRONLY || accessMode == O_RDWR) printf("file is writable\n");

- 我们设置cmd为F_SETFL就可以写入啦

int flags; flag = fcntl(fd, F_GETFL); if (flags == -1) errExit("fcntl"); flags |= O_APPEND; if (fcntl(fd, F_SETFL, flags) == -1) errExit("fcntl");

Relationship Between File Descriptors and OpenFiles

- 一个file被打开一次就会创建一个open file, 一个file可以被打开多次,当然也就可 以有多个open file

- open file创建的过程会返回file descriptor,这让人很容易产生"file descriptor和 open file是一一对应的"这样的错觉.其实这是错误的想法:一个open文件可以对应多个 file descriptor, 而且这些file descrptor可以在不同的process里面

- 为了了解为什么会有这种机制,我们先看下图

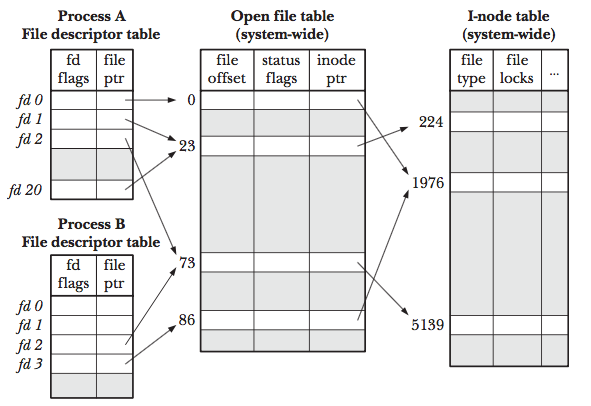

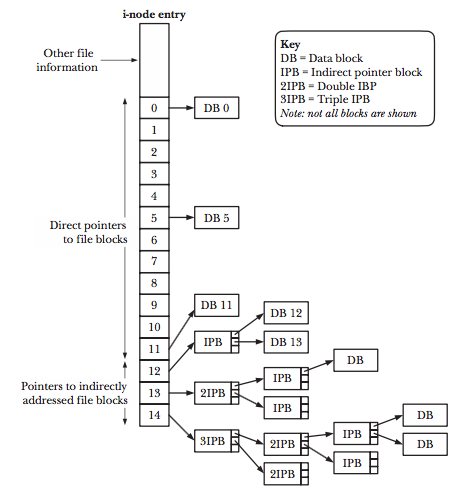

Figure 1: fd-ft-inode.png

- 对于每一个process,kernel都会维护一个open file descriptor table, 其中每个entry

都记录了单个file descriptor的信息, 包括:

- 这个file descriptor的 controlling flag

- 一个指向open file handler的指针

- 对于整个系统,kernel维护了一个open file table, 其中每个entry都记录了单个open

file的信息, 包括:

- current file offset(read(), write()会更新这个offset, 而lseek()可以设置任意的值)

- status flag:打开文件的时候设置的一些文件特性

- access mode: 可读,可写,还是即可读又可写

- signal-driven I/O的设置

- 一个指向i-node object的指针

- 对于每个file system(注意一个host上面可能有好几个文件系统, 一个分区就是一个

文件系统), 都会创建一个i-node table, 其中每个entry都是一个inode的信息.包括:

- file type and permission

- 指向文件拥有的所有的lock的列表

- file 的一系列属性

- 从上图中,我们也可以看到如下特别的地方:

- 在process A里面, descriptor 1和20都指向了同一个open file,这个可以通过调用 dup(), dup2(), fcntl()来实现

- 同样的process A里面的fd2和process B里面的fd2都指向了同一个open file handle 这种情况在fork的时候就会出现(还记得stdin stdout, stderr么)

- 再看process A的fd0和process B的fd3指向了不同的open file handle. 但是这两个 file handle指向了同一个i-node. 在不同进程中打开同一个文件,会出现上述情况.

- 从上面的讨论,我们可以得到如下结论:

- file descriptor自己的flag(比如close-on-exec flag是自己的)即便是fd被复制(通 过dup()等),但是更改其中一个fd的fd flag不会影响另外一个

- 但是open file的flag都是fd之间共享的,通过一个fd更改这些flag是会影响到其他

fd的,比如:

- access mode (O_WRONLY)

- status flag (O_SYNC)

- offset (write(), read(), lseek()等可以更改)

Duplicating File Descriptors

- bash里面有个"将stderr和stdout都redirect到同一个log文件里面的操作", 如下

i309511@ tmp $ cat print_12.py import sys sys.stdout.write('STDOUT\n') sys.stderr.write('STDERR\n') i309511@ tmp $ python print_12.py STDOUT STDERR i309511@ tmp $ python print_12.py > output.txt STDERR i309511@ tmp $ cat output.txt STDOUT i309511@ tmp $ python print_12.py > output2.txt 2>&1 i309511@ tmp $ cat output2.txt STDERR STDOUT

- 我们可以看到,再使用了"2>&1"之后,stderr也成功的进入了output2.txt, 这里用到的

技术其实就是duplicate一个file descriptor, 假设我们只有fd 0, 1, 2和output.txt

的fd3:

- stdout fd1肯定是指向open file handle for output.txt的(因为`>`指定了这个文件)

- 我们使用dup2()命令把stderr fd2也指向open file handle for output.txt

#include <unistd.h> dup2(1, 2);

- 如果用图形化表示,就是上图中process A的fd1和fd20共享open file handle.

- 我们处理这种fd"重新选择open file handle"的情况有三种function:

- dup: 只能保证用"尽可能小"的fd

- dup2: 可以先关闭newfd已有open file handle,然后重新联系就是先close然后dup

- fcntl: 更灵活的dup,不能自己close

File I/O at a Specified Offset: pread() and pwrite()

- 前面我们讲到,一个文件被打开就会创建一个open file的结构体,里面存着current

file offset(也就是read write到哪里了), 如果我们不想改动这个current file

offset, 额外的指定一个offset来读取和写入,那么就要用到

#include <unistd.h> ssize_t pread(int fd, void *buf, size_t count, off_t offset); /* Returns number of bytes read, 0 on EOF, or –1 on error */ ssize_t pwrite(int fd, const void *buf, size_t count, off_t offset); /* Returns number of bytes written, or –1 on error */

- 所有调用pread()和pwrite()的函数,都必须支持lseek(),因为其实pread()就是等于如

下几个call的集合

off_t orig; orig = lseek(fd, 0, SEEK_CUR); /* save current offset */ lseek(fd, offset, SEEK_SET); s = read(fd, buf, len); lseek(fd, orig, SEEK_SET); /* restore original file offset */

- 这种不改动current file offset的读取system call对于multithread应用非常的重要:

- 一个process里面的thread都是共享fd的,也就共享了open file里面的current file offset.

- 多个thread使用pread()或者pwrite()就可以不用担心相互打扰,而产生race condition 了(如果在两个thread里面使用lseek(),则肯定会出现race condition)

Scatter-Gathr I/O: readv() and writev()

- 就是将文件内容读取(或者写入)到多个buffer

#include <sys/uio.h> ssize_t readv(int fd, const struct iovec *iov, int iovcnt); /* Returns number of bytes read, 0 on EOF, or –1 on error */ ssize_t writev(int fd, const struct iovec *iov, int iovcnt); /* Returns number of bytes written, or –1 on error */

- 其中的iovec是一个结构体

struct iovec { void *iov_base; /* Start address of buffer */ size_t iov_len; /* Number of bytes to transfer to/from buffer */ };

- 这两个写入或者读取操作都是在一个system call里面完成的, 我们也不会畏惧其他也 拥有这个fd的process(或者thread)在这期间对文件做什么(2.6开始, system call可以 被interrupt,如果readv()或者writev()被抢占的话,上述system call会失败)

- 将readv, writev和pread, pwrite结合就形成了批量写入(读取)文件的多线程版本

#define _BSD_SOURCE #include <sys/uio.h> ssize_t preadv(int fd, const struct iovec *iov, int iovcnt, off_t offset); /* Returns number of bytes read, 0 on EOF, or –1 on error */ ssize_t pwritev(int fd, const struct iovec *iov, int iovcnt, off_t offset); /* Returns number of bytes written, or –1 on error */

Truncating a File: truncate() and ftruncate()

- 更改文件的大小,多则增加,少则补零

#include <unistd.h> int truncate(const char *pathname, off_t length); int ftruncate(int fd, off_t length); /* Both return 0 on success, or –1 on error */

- truncate()是唯一一个可以不先调用open()就能做IO操作的system call

Nonblocking I/O

- 当我们打开一个文件的时候,可以设置一个flag为O_NONBLOCK,一旦设置有如下好处:

- 如果文件不能被马上打开,那么open()就返回error,而不是blocking在那里等待文件 相应.

- 一旦通过这次open()打开以后,这个open file handle就拥有了nonblocking属性,所 有在这个open file handle所指向的fd上做的其他IO操作,都是nonblocking的.

- O_NONBLOCK的设置对于如下文件类型都适用:

- device

- pipe

- FIFO

- socket

- 对于pipe和socket来说,由于其不是被open()所打开的,所以还要使用fcntl() F_SETFL 来设置这个域.

- 我们会发现上面列出的O_NONBLOCK设置所应用的范围不包括普通文件(regular file), 这是因为kernel buffer cache的机制保证了regular file永远不会fail

I/O on Large Files

- 32位机器上面的offset最大为2**31-1 bytes,大概是2GB,所以需要一些处理.

- 64位机器上,现阶段还没有遇到这些问题.

The /dev/fd Directory

- 对于每个process来说,kernel都为它提供了一个特殊文件夹叫做/dev/fd, 这个文件夹

里面的文件都是以fd的名字来命名的,比如0,1,2代表standard input, output,error

那么shell这个process的/dev/fd下面至少有这三个文件

vagrant@vagrant:/dev/fd$ ls -l total 0 lrwx------ 1 vagrant vagrant 64 Jul 28 04:25 0 -> /dev/pts/0 lrwx------ 1 vagrant vagrant 64 Jul 28 04:25 1 -> /dev/pts/0 lrwx------ 1 vagrant vagrant 64 Jul 28 04:25 2 -> /dev/pts/0 lrwx------ 1 vagrant vagrant 64 Jul 28 07:05 255 -> /dev/pts/0

- 我们可以把/dev/fd/FD_NUM,当成是文件来用.

- 还记得xargs么,它能把管道前面计算的值放到最后

vagrant@vagrant:~$ diff t1.txt t2.txt 10a11 > AGAIN vagrant@vagrant:~$ ls t2.txt | xargs diff t1.txt 10a11 > AGAIN

- 如果我们想比较的是diff t2.txt t1.txt 而不是diff t1.txt t2.txt怎么办呢,bash

有个特殊的符号叫做"-",代表standard output

vagrant@vagrant:~$ cat t2.txt | diff t1.txt - 10a11 > AGAIN vagrant@vagrant:~$ cat t2.txt | diff - t1.txt 11d10 < AGAIN

- 但是"-"广泛的使用于bash命令行,有很多解释,很容易出现解析失误的情况,这个时候

/dev/fd/FD_NUM就起作用了(但是比起xargs还是有差距,xargs是逐个的把结果提供

给后面的命令)

vagrant@vagrant:~$ cat t2.txt | diff - t1.txt 11d10 < AGAIN vagrant@vagrant:~$ cat t2.txt | diff /dev/fd/0 t1.txt 11d10 < AGAIN

- 还记得xargs么,它能把管道前面计算的值放到最后

Creating Temporary Files

- 我们可以通过如下的两个system call创建temp文件:

- mkstemp的参数template是会更改的,所以要使用character array

#include <stdlib.h> int mkstemp(char *template); /* Returns file descriptor on success, or –1 on error */

- tmpfile在打开文件的时候,设置了O_EXCL flag, 这个flag能够保证临时文件名不可 能存在, 也不会和'其他process同时创建的文件'重名.

- mkstemp的参数template是会更改的,所以要使用character array

Chapter 06: Processes

Processes and Programs

- process是program的executing状态.所以program里面就要包括所有描述process运行

时刻的信息, 这些信息包括:

- Binary format identification: 每个program都会采用一种meta格式,好让kernel

"有章可循"的解析文件,常见的类型有:

- assembler output (如今不常用)

- Common Object File Format(如今不常用)

- Executable and Linking Format(ELF). (当下默认的标准)

- Machine-language instructions: 机器语言其实就是汇编,程序的逻辑都是这部分 控制

- Program entry-pint address: 说明了文件从"汇编语言"的何处开始运行

- Data: 用来初始化变量的数字,以及literal constant(比如字符串)

- Symbol and relocation tables: 标记function, variable的位置和名字.这些信息 对于debug非常有用

- Shared-library and dynamic-linking information:列出需要链接的"动态链接库" 和linker的地址

- Other information: 还有其他一些信息

- Binary format identification: 每个program都会采用一种meta格式,好让kernel

"有章可循"的解析文件,常见的类型有:

- 一个program可以被运行多次,每次都是一个不同的process.

- 在前面介绍的这些知识的情况下,我们能给process一个更精准的定义:process其实是kernel

定义的一种抽象个体, 这种抽象个体用来存储运行一次program所需要的资源

A process is an abstract entity, defined by the kernel, to which system resources are allocated in order to execute a program

- 从kernel的角度去理解,所谓的process就是一系列的user-space的内存,这些内存包含

以下信息:

- program code

- program code使用的variable

- 一系列表示process状态的kernel data,比如:

- virutal memory table

- table of open file descriptors

- signal delivery and handling

- process resource usage and limit

- current working directory

Process ID and Parent Process ID

- 每一个process都有自己的ID叫做PID,pid作为唯一的标示,有其重要的作用,比如kill() 就是以specific process ID为参数,关闭那个process

- getpid() system call就是用来返回调用process的PID

#include <unistd.h> pid_t getpid(void); /* Always successfully returns process ID of caller */

- Linux系统中,只有init的ID为1这是不变的,其他process的ID为什么并不总是固定的

- Linux会限定本机创建的process的数目,这个数目为32767. 当这个数目用尽了以后,会 从300开始重新赋予新的process ID(当然这些ID是退出的process用剩下的)

- 从2.6版本开始,Linux把最大可使用的process的数目保存在了/proc/sys/kernel/pid_max

里面. 而且可以通过更改这个值来改变最大process的数目:

- 对于32bit系统来说,最大就是32768了,但是你可以选择一个较小的其他数目

- 对于64bit系统来说,最大是2**22(大概是4百万)

- 每个process都有自己的parent process,也就是创建自己的process,我们通过system

call getppid()来获取这个数值

#include <unistd.h> pid_t getppid(void); /* Always successfully returns process ID of parent of caller */

- process的parent有parent,最终的"root"是pid为1的init

- 如果一个child的parent在它运行之前就退出了,那么这个child的parent就会变成init

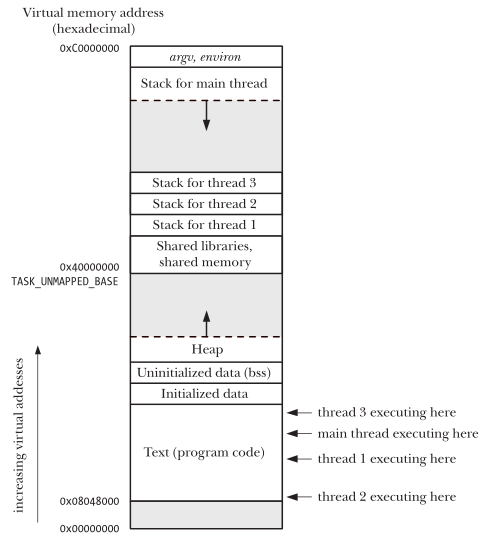

Memory Layout of a Processes

- 前面我们说了program的layout,当program运行起来以后,在内存中也有其相应的layout

这个layout由多个part组成,每个part叫做一个segment:

- text segment: 是保存着program里面的machine instruction. 这个segment是被标 记为read-only的,所以一个process不会不小心更改了"运行'自己的指令序列.因为 多个program可以多次运行成多个process,所以其实每个process里面的text segment 都是一样的,所以可以把一份program code的copy映射到多个process的virtual address space

- initialized data segment:保留着"代码中明确初始化了的"global 和 static的变 量,这个也是从program里面读取的.

- uninitialized data segment: 保留着"代码中没有明确初始化的"global 和 static 变量.这个不是从program里面读取的,program里面也没有.因为没有初始化,所以值都 是为0,从而program也不需要记录他们的值和位置.所以只有program在runtime变成 process的时候才真正分配"内存"给它们. 历史上这个区域叫做bss segment (block started by symbol)

- stack segment: stack是一种动态"生长"和"缩退"的segment. 每当为一个function "自动"分配虚拟内存的时候,其参数,local variable, 返回值也会"紧接着"分配虚拟 内存.当这个function调用完成后,这些内存又"自动"释放. stack segment是从"高 地址"向"低地址"生长的

- heap segment: 是在运行的时候,动态分配的内存. heap segment是从"低地址"向"高 地址生长"的,生长的终点就是stack segment的顶点.换句话说stack和heap是公用地 址的(相对生长),当然这个地址很大.

- 我们可以使用size命令来查看一个可执行文件的segment大小(只有text data bss大小)

剩下的dec是十进制,hex是十六进制表示的三个部分的总大小

vagrant@vagrant:~/tmp$ size a.out text data bss dec hex filename 1131 552 8 1691 69b a.out

- 理解这三个区域是'在process创建的时候就存在,且大小不变'这件事情是非常重要的.

这有助于让我们理解某些返回值为pointer的library function:

- 这些library function返回的pointer必须指向data或者bss的内存地址,因为只有这 两块地址是不跟随function消失而消失,同时也是可写的.

- 一个library function返回了'指向static分配的内存pointer'的话,就必然无法做到 reentrant(可重入). 因为static分配内存可能会被下一次的程序调用所覆盖

- 下面一个程序介绍了一个程序每个部分都属于哪个segment

#include <stdio.h> #include <stdlib.h> char globBuf[65535]; /* Uninitialized datat segment */ int primes[] = { 2, 3, 5, 7}; /* Initialized data segment */ static int square(int x) { /* Allocated in frame for square() */ int result; /* Allocated in frame for square() */ result = x * x; return result; /* Return value passed via register */ } static void doCalc(int val) { /* Allocated in frame for doCalc() */ printf("The square of %d is %d\n", val, square(val)); if (val < 1000) { int t; /* Allocated in frame for doCalc() */ t = val * val * val; printf("The cube of %d of %d is ", val, t); } } int main(int argc, char *argv[]) { static int key = 9973; /* Initialized data segment */ static char mbuf[10240000]; /* Uninitialized data segment */ char *p; /* Allocated in frame for main() */ p = malloc(1024); /* Points to memory in heap segment */ doCalc(key); return 0; }

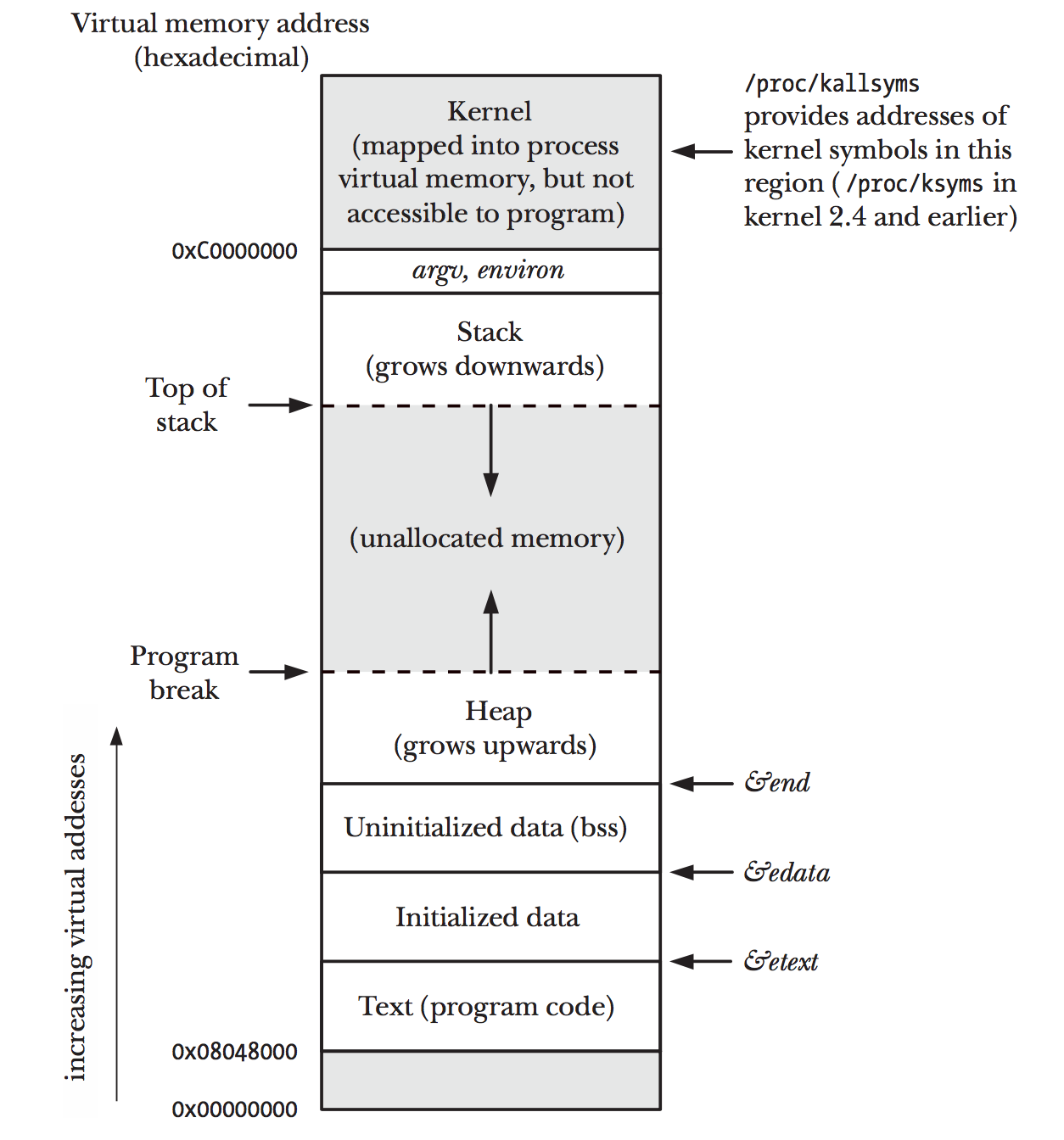

- 下图则展示了一个典型的4G虚拟内存是如何在一个process里面映射的(注意灰色部分 是process无法使用的地址范围).

- 我们注意到0xC0000000以上到FFFFFFFF,是kernel的空间,虽然被映射到了process的virtual

memory,但是对于program来说,却不能访问(我们注意到这个区域大小是4G中的1G,因为

11占了00,01,10,11中的四分之一)

Figure 2: memory-layout-process.png

irb(main):013:0> "C0000000".to_i(16).to_s(2) "C0000000".to_i(16).to_s(2) => "11000000000000000000000000000000"

Virtual Memory Management

- 我们前面讨论的process的内存layout,其实是基于了virtual memory的系统.virtual memory系统的设计是基于提高CPU和RAM的利用率.

- 之所以virtual memory能够提高cpu和内存的利用率,是因为大多数的program在locality

(定位)方面有如下特点:

- spatial locality: program有很大可能访问"刚才访问的内存"附近的内存

- temporal locality: program有很大可能访问"刚才访问过的内存"

- 这两种locality决定了:当我们执行program的时候,其实我们只需要有一小部分address space真正的在内存里面就好了.

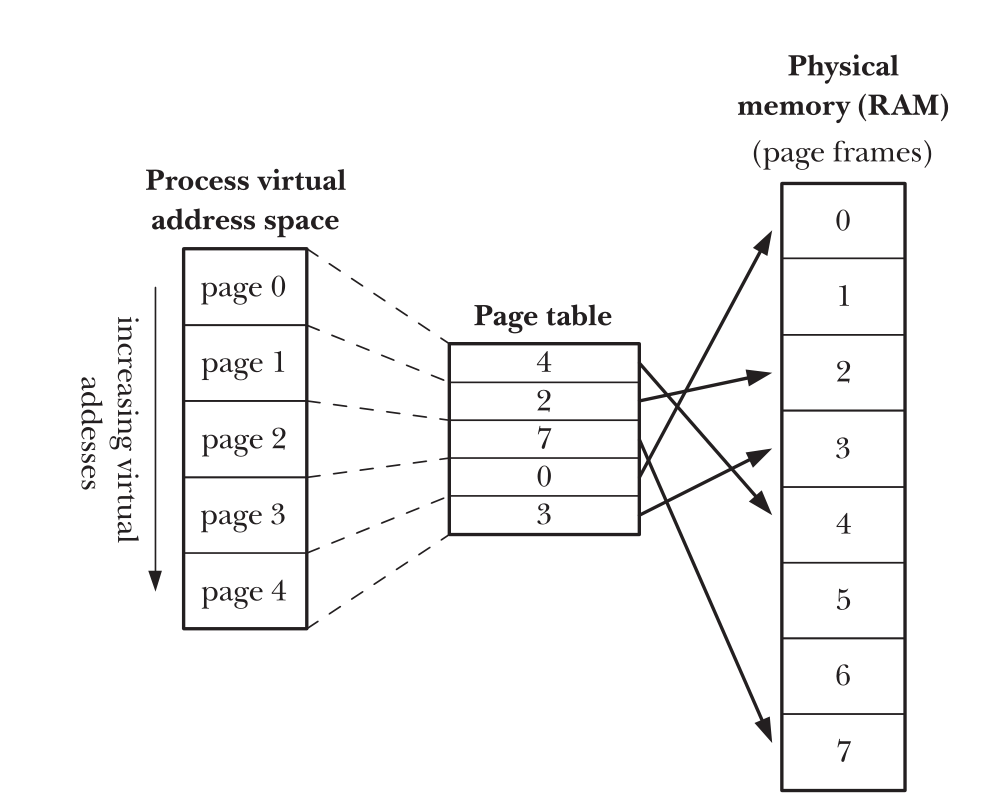

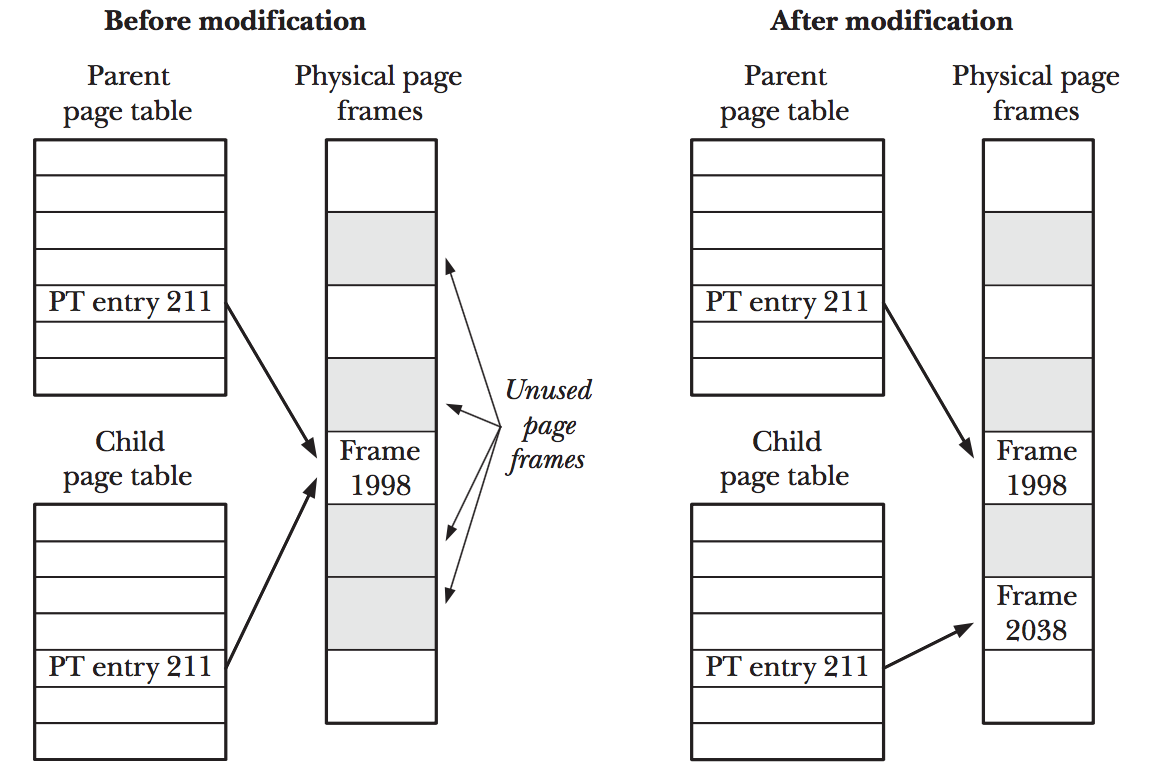

- virtual memory系统的要点如下:

- virtual memory就是把program使用的内存分成一个一个的小块(叫做page),同时RAM 也会把自己分成和page大小相同的单位,叫做page frame

- 在运行的时候只有一小部分的page是真正放在page frame里面的

- 如果process用到了一个page,但是这个page不在page frame里面,那么会触发page fault 一旦出现page fault,kernel就会停止当前的process运行,待它把相应内存page放入 page frame以后,再继续运行刚才的process

- 为了能将address space里面的page和RAM里面的page frame进行一一对应, kernel为

每一个process都配备了一个page table. page table里面,要么指明了page所在的page

entry,要么直接说明这个page还在硬盘上

Figure 3: page-table.png

- 并不是process的每个address space都需要page table,因为大部分的address space 都没有使用,如果process试图访问一个没有page-table entry对应的address space的 时候会触发SIGSEGV signal. 需要注意出现了SIGSEGV肯定是地址访问的违法,如果地 址是新创建,还没有对应的page table, page fragment的话,kernel会"自动的"分配新 的page table给process. 而不会发出signal

- process valid的virtual address (也就是有page table entry的地址)是随着其运行

而不断改变的,改变的情况有如下:

- stack向下(低地址)生长的时候,到了一个自己原来从来没到过的低地址.(stack可能 先向下生长,然后回退)

- 通过system call brk(), sbrk(), malloc分配heap地址,并且把heap的最高地址program break提高到原来没到过的高地址(heap可能先向上生长,然后回退)

- System V shared memory合并和分离的时候

- 当使用mmap()和munmap()被调用的时候.

- Virtual memory机制将process的address和珍珠的RAM的物理内存进行了分割,这带来了

很多的好处:

- process之间相互隔离,process和kernel之间相互隔离.因为不同的process的page table entry指向不同的物理内存就可以做到

- 有些时候,process还希望共享一些内存,这个时候,让不同的process的page table

entry指向相同的物理内存,就做到了share内存.通常需要share的情况有如下:

- 多个process运行同一个program的时候,text segment可以share(而且是只读的)

- 多个process之间相互通过调用shmget()和mmap()system call分享内存进行通信 (其实也是Linux处理线程的方法)的时候.

- 内存的保护机制也变的容易,不同的process有不同的page table entry指向同一块 page fragment.可以在page table entry里面设置属性,那么对同一个RAM里面的内 容有些process可读,有些process可写就做到了.

- 编程人员和编译器链接器不必考虑program在内存中的物理映射了

- 因为只有一小部分program在内存里面,那么我们可以在内存中存更多的进程, 进程 使用内存的总量可以超过物理RAM大小.因为总有多个process在运行,计算机CPU的利 用率也就提高了.

The Stack and Stack Frames

- 对于Linux 32位机器来说(其他Unix-like的机器也差不多). stack从process可达的最 高地址处开始往下生长(朝着heap),每个processor都有一个专门的寄存器stack pointer 来记录stack fragment的最底处(current top of stack segment)

- 每当有新的function被调用,就会给stack分配额外的frame(增加page entry指向page entry),但是我们注意的是,当function调用完了之后,stack segment只是向回搜索(stack pointer变更),而已经分配给stack的page segment是不会回收的(下次再来到这个地方 直接使用)

- 因为存在着kernel stack这么一说,所以我们有时候会使用user stack来指代stack.kernel stack是非常特殊的一种stack,是kernel为每一个process准备的,保留system call(因 为system call其实也是function)运行信息的stack

- 好了,还是回到user stack,通常来说,user stack会保存如下的内容:

- function arguments and local variable: 调用一个function的时候.都会有些参数 而且函数内部会有一些local variable(在c语言里面local variable也叫automatic variable,因为它是自动分配内存的),这些都会自动被分配到stack frame里面.当然 了这些参数和local变量会随着函数调用的完成而丢失

- call linkage information: 每个function都会使用一些CPU寄存器(比如program

counter,指向下一条机器指令),每当一个function调用另外一个function的时候,当

前所有寄存器的值都要保存起来(到stack里面),因为被调用的function返回的时候,

我们能restore寄存器原来的值.比如我们前面main调用doCalc(),再调用square()的

例子,其stack如下

+----------------+ | Frame for | | main() | +----------------+ | Frame for | | doCalc() | stack ---> +----------------+ pointer | Frame for | | square() | +-------+--------+ | | Direction of | stack growth V

Command-Line Arguments(argc, argv)

- argc和argv我们都很熟悉了,是command line传过来的参数的个数和每个参数的字符串

需要注意的是command本身是占了数组的第一个位置

#include <stdio.h> int main(int argc, char *argv[]) { int j; for (j = 0; j < argc; j++) printf("agrv[%d] = %s\n", j, argv[j]); return 0; } /**************************************************/ /* <===================OUTPUT===================> */ /* $ ./necho hello world */ /* agrv[0] = ./necho */ /* agrv[1] = hello */ /* agrv[2] = world */ /**************************************************/

Environment List

- 除了参数字符串数组, 我们还有一个"环境变量字符串数组",只不过,环境变量字符串 数组的值是"name=value"的形式.

- 因为process在创建的时候,从parent那里获得了一份parent的环境变量,换句话说,这 也是一种parent和child进行通信的方式.

- shell是设置环境变量最常见的地方:

- 对于bash来说设置环境变量如下(移除是unset):

$ export SHELL=/bin/bash - c shell的设置方式如下(移除是unsetenv):

setenv SHELL /bin/bash

- 对于bash来说设置环境变量如下(移除是unset):

- c语言里面也设计了一个global变量environ字符串数组来存储所有的环境变量

#include <stdio.h> extern char **environ; int main(int argc, char *argv[]) { char **ep; for (ep = environ; *ep != NULL; ep++) puts(*ep); return 0; } /**************************************************/ /* <===================OUTPUT===================> */ /* SHELL=/bin/zsh */ /* TERM=dumb */ /* .... */ /**************************************************/

Performing a Nonlocal Goto: setjmp() and longjmp()

- 环境变量还有一个意想不到的作用就是为nonlocal jump保存环境.

- 所谓nonlocal jump是指的可以跳出当前的function环境而放弃中间调用的function直 接回到更上层(或者甚至是最上层main)的方法.而普通goto只能在本function jump

- nonlocal jump是依靠两个函数

#include <setjmp.h> int setjmp(jmp_buf env); /* Returns 0 on initial call, nonzero on return */ /* via longjmp() void longjmp(jmp_buf env, int val); */

- 用法是,在某处设置setjmp, 在调用longjmp的时候,返回到setjmp.就好像setjmp刚调

用过一样,只不过:

- setjmp第一次返回返回值为0

- setjmp给longjmp触发返回,返回值为longjmp设置的val(此val设置0无效,会自动设置 为1,因为setjmp第一次就返回0)

Chapter 07: Memory Allocation

Allocating Memory on the Heap

- heap区域是一块紧跟着bss segment的segment, process可以通过调整这个区域的limit: program break来增加或者减少heap大小

- C程序员一般都会使用malloc来获取heap memory, malloc是一个library function,它 是通过在内部调用system call brk()和sbrk()来实现的

Adjusting the Program Break: brk() and sbrk()

- 如果不考虑负责的情况,那么更改heap的大小,其实就是更改program break的值

- 一旦program break增加了,那么新增加区域的内存地址对于process来说就肯定可以访 问了,但是这些address page并没有对应的page table, 也就不可能存在对应的page fragment,只有真正的访问发生的时候出现了,kernel会自动的真正着手去创建相应的 page table,以及相应的page fragment

- Unix-like系统用来更改program break大小的两个system call 如下

#include <unistd.h> int brk(void *end_data_segment); /* Returns 0 on success, or –1 on error */ void *sbrk(intptr_t increment); /* Returns previous program break on success, or (void*) -1 on error */

- brk()会把program break设置到end_data_segment(注意end_data_segment在32位上

面就是一个32的地址)的位置, 当然了因为virtual memory 一般都是按照page分配的

,所以end_data_segment都会round up到page size的倍数.可惜的是,我们在mac和linux

平台上都实验过了,并不会round up

#include <unistd.h> #include <stdio.h> int main(int argc, char *argv[]) { void *p; int size = 1; p = sbrk(0); printf("size : %d, p : %p \n", size, p); p = sbrk(size); p = sbrk(0); printf("size : %d, p : %p \n", size, p); return 0; } /**************************************************/ /* <===================OUTPUT===================> */ /* size : 1, p : 0x106295000 */ /* size : 1, p : 0x106295001 */ /**************************************************/

- sbrk()就是把program break增加increment大小的位置, 在Linux上这是一个library function,它内部调用了brk().

- sbrk()的返回值是上次program break的位置,所以sbrk(0)就可以返回当前program break 的位置.

- 如果你试图把program break通过brk()设置到比原来的program break还小,那么着显 然会导致灾难(通常是segmentation fault,也就是SIGSEGV)

- 而program break可以设置的最大值,则是不固定的,因为这个值和很多其他的值相关,

比如:

- 每个process都有resource limit,resource limit里面也包含对data segment的大 小要求

- shared memory segment的大小,

- shared library的大小

- SUSv3开始, brk()和sbrk()已经退出历史舞台了.因为它们诞生于virtual memory之前 不太善于管理不连续的内存.

Allocating Memory on the Heap: malloc() and free()

- 一般来说C程序员都会使用malloc()和free()来获取heap内存的,因为它们有更多的优点:

- 是C语言标准的一部分

- 在多线程代码中更容易使用

- 提供了小额内存的申请方式

- deallocate的时候没有直接改动program break,而且维护一个未分配列表.性能更好

- malloc分配的最小单位为byte,声明如下

#include <stdlib.h> void *malloc(size_t size); /* Returns pointer to allocated memory on success, or NULL on error */

- malloc的返回值为void*,可以cast成任意类型的指针.

- malloc(0)在Linux返回一个可以被free()的最小的内存块, SUSv3规定也可以选择返 回NULL

- 如果memory不能够成功分配了(比如program break到了最大值),那么我们要返回NULL, 并且设置errno.所以检查返回值对malloc非常重要

- free是释放heap内存的命令,其参数ptr一定是malloc(或相同类型命令)返回的地址

#include <stdlib.h> void free(void *ptr);

- free()一般来说不会去真的把program break给降低,而是把这些内存放到free block

的list上去,等待下次被malloc分配.这么做有如下几点原因:

- 一般来说被free()的内存大部分都不是"紧挨着"program break的地址,所以降低program break并不现实

- 最大限度的降低sbrk()调用的次数,我们前面讲过了,system call还是比普通的c function要消耗更多的资源的.

- 因为程序通常来说会在一段时间内频繁的申请和释放

- free()的参数为NULL并没有事,但是其参数如果被free调用两次,那通常意味着大的灾 难.

- 下面的例子我们可以看到free的用法,其实free()会在大量连续的空间(通常是128KB

以上)被释放的情况,将program break下调(使用sbrk()). 下例中只有最后一种情况下

才会真正的更改program break

#define _BSD_SOURCE #include "tlpi_hdr.h" #define MAX_ALLOCS 1000000 int main(int argc, char *argv[]) { char *ptr[MAX_ALLOCS]; int freeStep, freeMin, freeMax, blockSize, numAllocs, j; printf("\n"); if (argc < 3 || strcmp(argv[1], "--help") == 0) usageErr("%s num-allocs block-size [step [min [max]]]\n", argv[0]); numAllocs = getInt(argv[1], GN_GT_0, "num-allocs"); if (numAllocs > MAX_ALLOCS) cmdLineErr("num-allocs > %d\n", MAX_ALLOCS); blockSize = getInt(argv[2], GN_GT_0 | GN_ANY_BASE, "block-size"); freeStep = (argc > 3) ? getInt(argv[3], GN_GT_0, "step") : 1; freeMin = (argc > 4) ? getInt(argv[4], GN_GT_0, "min") : 1; freeMax = (argc > 5) ? getInt(argv[5], GN_GT_0, "max") : numAllocs; if (freeMax > numAllocs) cmdLineErr("free-max > num-allocs\n"); printf("Initial program break: %10p\n", sbrk(0)); printf("Allocating %d*%d bytes\n", numAllocs, blockSize); for (j = 0; j < numAllocs; j++) { ptr[j] = malloc(blockSize); if (ptr[j] == NULL) errExit("malloc"); } printf("Program break is now: %10p\n", sbrk(0)); printf("Freeing blocks from %d to %d in steps of %d\n", freeMin, freeMax, freeStep); for (j = freeMin - 1; j < freeMax; j += freeStep) free(ptr[j]); printf("After free(), program break is: %10p\n", sbrk(0)); exit(EXIT_SUCCESS); } /**************************************************/ /* <===================OUTPUT===================> */ /* $ ./free_and_sbrk 1000 10240 2 */ /* */ /* Initial program break: 0x192b000 */ /* Allocating 1000*10240 bytes */ /* Program break is now: 0x22f3000 */ /* Freeing blocks from 1 to 1000 in steps of 2 */ /* After free(), program break is: 0x22f3000 */ /* $ ./free_and_sbrk 1000 10240 1 1 999 */ /* */ /* Initial program break: 0x1ad6000 */ /* Allocating 1000*10240 bytes */ /* Program break is now: 0x249e000 */ /* Freeing blocks from 1 to 999 in steps of 1 */ /* After free(), program break is: 0x249e000 */ /* $ ./free_and_sbrk 1000 10240 1 500 1000 */ /* */ /* Initial program break: 0x20bd000 */ /* Allocating 1000*10240 bytes */ /* Program break is now: 0x2a85000 */ /* Freeing blocks from 500 to 1000 in steps of 1 */ /* After free(), program break is: 0x25bf000 */ /**************************************************/

- 当一个process退出的时候,它所有的memory都会返回给系统(当然也包括申请的heap 里面的memory).所以如果程序运行时间短,理论上是可以不调用free()的,但是基于以 下原因还是最好调用free():明确的free()会让程序更易读

Implementation of malloc() and free()

- 虽然malloc()和free()的实现已经比brk()要好很多,但是依然非常容易用错,所以了解 其实现细节有一定积极作用.

- malloc()的实现相对简单:

- malloc()首先从free()创建的memory block free list里面寻找"最合适大小的" block

- 如果能够找到跟期望的内存大小一模一样的当然更好

- 如果能找到比期望的内存大的,也可以.把这块内存split,"最合适大小"的返回给用 户.剩下的还是放到memory block free list

- 如果没有一个block能够大于期望内存大小,那么就要使用sbrk()来申请大块内存了, 这种情况下,malloc()不是需要多少就sbrk多少,而是会多分配很多(一般是page的 整数倍大小)的内存

- free()的实现细节就充满了"黑科技":

- 当我们的free()把一块释放的内存放到free list的时候,free()是怎么知道它的大

小的呢?答案在于malloc,malloc在分配内存的时候,在返回的内存的前面(紧挨着)

的部分,保留了一块内存写下了当前内存块的大小.如下:

+-----------+---------------------------------+ | Length of | | | | Memory for use by caller | | block(L) | | +-----------+---------------------------------+ ^ | | | Address returned by malloc() - 更"黑"的科技是free()如何把一块内存加入到freelist:它征用了紧挨着length后面

的内存,把两个指针写进去了一个pre,一个next

+-----------+------------+-------------+---------------------+ | Length of | Pointer to | Pointer to | | | | Prev free | Next free | Remaining bytes of | | block(L) | block(P) | block(N) | fre block | +-----------+------------+-------------+---------------------+ ^ | | | Address returned by malloc()

- 当我们的free()把一块释放的内存放到free list的时候,free()是怎么知道它的大

小的呢?答案在于malloc,malloc在分配内存的时候,在返回的内存的前面(紧挨着)

的部分,保留了一块内存写下了当前内存块的大小.如下:

- 鉴于malloc()和free()的设计是如此的精妙,我们在使用它们的时候,要遵循以下的规

则:

- 当我们从heap申请到内存的时候,记住不要动内存指定的范围以外的内容

- free()两次malloc返回的内存是错误的,有时候free两次会返回SIGSEGV,但其实这是 一个unpredictable behavior

- 永远不要free一个不是来自malloc的指针

- 如果是一个long-running program,每一次的heap内存申请,必须对应一次heap的释 放.否则就会造成内存泄露

Other Methods of Allocating Memory on the Heap

- 我们还可以使用calloc为数组类型申请heap内存

#include <stdlib.h> void *calloc(size_t numitems, size_t size); /* Returns pointer to allocated memory on success, or NULL on error */

- 使用realloc()来扩大malloc()原来分配的空间,但是由于很多时候,heap的连续可用

空间不大,其实realloc()经常是重新分配一块空间,所以效率不高

#include <stdlib.h> void *realloc(void *ptr, size_t size); /* Returns pointer to allocated memory on success, or NULL on error */

- 有时候,想分配一个heap空间,但是希望它的地址从一个boundary的整数倍开始,那么

就有了

#include <malloc.h> void *memalign(size_t boundary, size_t size); /* Returns pointer to allocated memory on success, or NULL on error */

- SUSv3规范对上述情况提供的官方函数的声明如下

#include <stdlib.h> int posix_memalign(void **memptr, size_t alignment, size_t size); /* Returns 0 on success, or a positive error number on error */

Allocating Memory on the Stack: alloca()

- 和heap对应的stack(高地址向地地址生长),申请的时候,是使用函数alloca

#nclude <alloca.h> void *alloca(size_t size); /* Returns pointer to allocated block of memory */

- 和heap地址不同,我们不需要free()我们alloca的地址

- 如果不听的调用alloca(),那么stack地址会用完,进而发生stackoverflow,此时的程序 行为也是unpredictable的(很多情况下会得到SIGSEGV)

- 通常来说alloca()都会被malloc()快,这是因为:

- alloca()通常都是以inline code实现的

- alloca()的任务简单,只是更改stack pointer, 而malloc则要维护一个block free list

- alloca()不仅仅比malloc()快,而且更容易使用,因为:每当function结束的时候,会restore 寄存器,从而自动的把stack pointer寄存器的值更改为调用前的值.也就顺便释放了内 存.使用alloca()不会导致内存泄露

Chapter 08: Users and groups

The Password File: /etc/passwd

- 一般来说/etc/passwd包含着如下面一行所显示的多行的信息

mtk:x:1000:100:Michael Kerrisk:/home/mtk:/bin/bash

- 下面来分析下":"分开的各个部分的意义:

- mtk: 也就是用户名,登录的时候,就是使用用户名,我们的ls加上参数-l就会显示某 个文件属于哪个用户名

- x: 也就是encrypted password:一般来说这里会有13个字符的加密密码,但是由于现 在多采用"shadow password",也就是把加密密码放到/etc/shadow里面去.所以这里 就使用一个x作为"占位符". 如果/etc/shadow对应的密码为空,那么这个x也是空,也 就意味着用户可以不使用密码登录

- 1000:第一个1000是用户的UID,如果这个数字为0的话,那么意味着是超级用户(通常 是root). Linux2.2以前UID是使用了16位存储,所以最多用户为65535,Linux2.6开始 使用32位存储,则最大用户数则多的多了

- 1000:第二个1000是用户的GID,这个Group是用户序列的"第一个"group,也叫primary group

- Michael Kerrisk: 这个域叫comment,其实就是对username的description

- /home/mtk:这个是home文件夹,登录以后,这个域就变成HOME环境变量

- /bin/bash:这个是默认的shell,登录以后,这个域变成SHELL环境变量

The Shadow Password File: /etc/shadow

- 历史上,Unix系统是把密码存到/etc/passwd里面的,但是/etc/passwd里面又含有了太

多的"非密码"的信息,所以很多"低权限"的用户,也要有read /etc/passwd的权限.这就

造成了很多漏洞:

因为基本上所有的用户都有权限读取/etc/passwd,权限较低的用户可 以读取/etc/passwd里面权限较高用户的encrypted password,然后采 取"撞库"的方法猜测高权限用户的密码 - 出现上面错误的原因在于/etc/passwd的初衷为"只存储password",但是后来存储了太多

information类的信息.所有最好的办法是把密码单独存储在/etc/shadow里面(文件名字

就有一点'文不对题'了,但是为了兼容性只能忍了), 所以/etc/shadow里面的一行大概

如下

root:$6$5/5YIHUd$vYsjnBgYda/v8BaFlzTnM9CmGxEbgTvuZmiz0whhIY8/ GGndpB7W8Dar0/30MLL3IGGrjpXrzohGltJMOFVV//:16554:0:99999:7:::

The Group /etc/group

- "人以群分",出于对共享资源,文件控制权限等的考虑,把用户分成不同的组是一个很好 的做法.

- 历史上,曾经一个用户只能属于一个group,也就是在/etc/passwd里面制定的group,但是

后来一个user可以属于多个group,所以把group分到两个文件里面去存储:

- /etc/passwd里面存储的,是以用户为index,会列出用户的primary group

vagrant@vagrant:~$ cat /etc/passwd root:x:0:0:root:/root:/bin/bash vagrant:x:1000:1000:vagrant,,,:/home/vagrant:/bin/bash

- /etc/group里面存储的是以group为index. 会列出组的所有成员(当然在/etc/passwd

里面列举过的就不再列举了,比如`vagrant:x:1000:`这一行后面就没有其他用户.

vagrant@vagrant:~$ cat /etc/group adm:x:4:syslog,vagrant cdrom:x:24:vagrant,hfeng sudo:x:27:vagrant dip:x:30:vagrant plugdev:x:46:vagrant vagrant:x:1000: lpadmin:x:117:vagrant sambashare:x:118:vagrant docker:x:998:vagrant,hfeng

- /etc/passwd里面存储的,是以用户为index,会列出用户的primary group

- groups命令可以列出某个用户的所有groups

vagrant@vagrant:~$ groups vagrant vagrant : vagrant adm cdrom sudo dip plugdev lpadmin sambashare docker

- 我们来看一个/etc/group里面的item

docker:x:998:vagrant,hfeng

- 通过和/etc/passwd对比,我们也大概猜出它们的作用:

- docker:是groupname

- x:原来是密码,现在存在/etc/gshadow

- 998:就是GID,一般来说,GID为0 group root的ID

- vagrant,hfeng: 剩下的就是username 列表了.

Retrieving User and Group Information

- 获取用户信息的函数为

#include <pwd.h> struct passwd *getpwnam(const char *name); struct passwd *getpwuid(uid_t uid); /* Both return a pointer on success, or NULL on error; s */ /* ee main text for description of the “not found” case */

- 获取group信息的函数为

#include <grp.h> struct group *getgrnam(const char *name); struct group *getgrgid(gid_t gid); /* Both return a pointer on success, or NULL on error; */ /* see main text for description of the “not found” case */

Password Encryption and User Authentication

- Unix系统的密码是以"不可逆的单向加密"的方法进行保存的,也就是和我们网站存储用 户密码的方法是一样的.验证密码的方式也是把用户输入的密码"加密"后和数据库中的 结果进行对比.

Chapter 09: Process credentials

Real User ID and Real Group ID

- real user ID 和 group ID是指的当前的process是属于哪个用户和group的.

- 一般我们的process都是从shell里面启动的.所以其real user ID和group ID都是从login shell里面获取的.

- 而login shell的real user ID和group ID都是从/etc/passwd里面的第三位(如下1000

为real user ID)和第四位(如下100为group id)获取的

mtk:x:1000:100:Michael Kerrisk:/home/mtk:/bin/bash

Effective User ID and Effective Group ID

- 对于大多数Unix系统来说(Linux有些许不同,因为引入了file User ID, file Group

ID的概念来处理文件访问权限), 用来决定一个process是否可以执行某些权限的操作:

- effective user ID

- effective group ID

- supplementry group ID

- 而一个process拥有的effective user ID为0的话, 这种process叫做privileged process 有很多system call只能被privileged process来调用

- 通常来说,effective user & group ID是和real user & group ID是一样的.但是我们

可以通过如下的两种方式改变:

- 调用system call, 这个可以在process启动以后用来改变自己的effective user &

group ID

int setuid(uid_t uid); int setgid(gid_t gid);

- 使用set-user-ID和set-group-ID,这个是要在process启动之前就得设置

- 调用system call, 这个可以在process启动以后用来改变自己的effective user &

group ID

Set-User-ID and Set-Group-ID Programs

- 更改process effective user&group ID的一种比较"受限制"的改法是使用set-User&Group-ID 因为它只能将effective user&group ID改成executive文件owner的ID和group ID.

- 像其他的文件一样, executive文件也有自己的user ID和group ID来表明自己的归属. 我们set-UID和set-GID的办法其实就是"set effective IDs with UID or GID".

- 因为是执行以前就可以设置的办法,那么一定可以在文件系统的权限中有所说明,说明

的的位置其实是和rwx里面的x相同,因为只有可执行文件才会去设置set UID或者set PID.

vagrant@vagrant:~/tmp$ ls -al a.out -rwxrwxr-x 1 vagrant vagrant 8600 Jul 31 08:05 a.out vagrant@vagrant:~/tmp$ chmod u+s a.out vagrant@vagrant:~/tmp$ ls -al a.out -rwsrwxr-x 1 vagrant vagrant 8600 Jul 31 08:05 a.out vagrant@vagrant:~/tmp$ chmod g+s a.out vagrant@vagrant:~/tmp$ ls -al a.out -rwsrwsr-x 1 vagrant vagrant 8600 Jul 31 08:05 a.out

- 通过设置set-UID, set-GID, 一般process都会得到"额外"的权限,特别是某个文件是

属于root的时候,一旦设置为set-UID,其effective UID就为0,也就变成了privileged

process. 所以有时候在一些权限不大的shell想运行root级别的操作的时候,就得依靠

set-UID, set-GID.比如

- passwd, 我们的普通用户也需要更改密码, 但是改密码是root级别的权限

- su, 我们普通用户要临时切换到其他用户shell, 但是切换用户是root级别的权限

Saved Set-User-ID and Saved Set-Group-ID

- saved set-uid, saved set-gid看名字就是为了set-uid, set-gid所准备的,它们的作

用是:

把effective User ID和effective Group ID的值都复制一遍存下来. - 存起来的作用是因为effective UID&GID只能在如下两个值之间变动,所以其实saved set

UID 和 saved set GID其实就是一个effective UID的"备份". 当然,这个备份的作用

只有在set UID&GID的时候才有作用,因为只有在那个时候real UID&GID和effective

UID&GID的值才不一样!

- real UID&GID

- saved UID&GID

File-System User ID and File-System Group ID

- 传统的Unix系统只有effective UID&GID来负责权限方面的操作,而Linux则是从这个权 限操作里面取了"文件相关操作"给予了一个新的ID File-System UID&GID.

- 而绝大多数的情况下file-system UID&GID和effective UID&GID的值是一模一样的,只

有在调用Linux专用的两个函数的时候,两个值才会有所不同, 这两个值是:

- setfsuid()

- setfsgid()

- 这个设置只是为了Linux 2.0之前的兼容性,现在通常不予考虑

Supplementary Group IDs

- 除了primary group, Linux还支持每个用户拥有supplementary group,而一个shell启 动的时候,就会从/etc/groups里面继承某个用户的supplementary group的设置,而从 这个shell启动的process也就自动拥有了这些个supplementary Group

- 可以使用如下命令来查看一个process的supplementary group

vagrant@vagrant:~$ ps -eo supgid,comm | grep python 24,998,1000 python

Chapter 10: Time

- 对于一个program来说,我们只对如下的两个时间感兴趣:

- real time: 从某一个固定时间算起,所经历的时间. 这对需要打时间戳的程序非常的 有用

- process time: 测量一个process所使用的CPU时间.检查和优化一个程序的时候,测量 cpu使用时间非常有用

Calendar Time

- 无论你的物理位置是什么(location设置了什么), Unix系统在内部是通过计算自己和 Epoch之间的"秒数"来记录时间的.

- 所谓的Epoch就是:格林尼治时间(UTC)的1970年1月1号午夜.

- Calendar time在Unix是SUSv3标准中是以time_t的类型存储的,在32-bit系统中,这是 一个signed integer, 其最大表示的时间是2038年的某一天,所以32位机器在那天会出 现问题.

- gettimeofday() system call会返回calendar time在tv里面

#include <sys/time.h> int gettimeofday(struct timeval *tv, struct timezone *tz); struct timeval { time_t tv_sec; /* Seconds since 00:00:00, 1 Jan 1970 UTC */ suseconds_t tv_usec; /* Additional microseconds (long int) */ };

- 我们还会看到这个函数"似乎"还返回了表示timezone的tz, 但这是为了历史兼容性,这 个值一直会是NULL的

- 还有一个精度比较低的返回从Epoch到现在"秒数"的system call,只返回秒,没有毫秒

#include <time.h> time_t time(time_t *timep);

- 这个函数会从1返回值2timep两个地方返回"秒数",而常用的方法是"直接给一个NULL指

针"

t = time(NULL);

Time-Conversion Functions

- "秒数"毕竟不容易读,glibc还为我们提供了一系列的library function来把"秒数"转化 为人类可读的字符串

Converting time_t to Printable Form

- ctime()函数是把time_t 值转化成printable的样式

#include <time.h> char *ctime(const time_t *timep); /* Returns pointer to statically allocated string terminated by */ /* newline and \0 on success, or NULL on error */

- 使用方法如下,下面的例子你必须得小心的是ctime返回的是statically allocated

string, 而且这个static的字符串还会被"重复利用", 也就是说下次调用ctime()的

时候,这个static内存还会被"重复"使用.

#include <time.h> #include <stdio.h> int main() { time_t ptr = 0; time(&ptr); char *readable1 = ctime(&ptr); printf("Reaable1: %s\n", readable1); sleep(2); time(&ptr); char *readable2 = ctime(&ptr); printf("Reaable2: %s\n", readable2); printf("readable add is: %p \n" , readable1); printf("readable add is: %p \n" , readable2); printf("Reaable1: %s\n", readable1); printf("Reaable2: %s\n", readable2); } /**************************************************/ /* <===================OUTPUT===================> */ /* Reaable1: Fri Aug 7 06:57:17 2015 */ /* */ /* Reaable2: Fri Aug 7 06:57:19 2015 */ /* */ /* readable add is: 0x7f4776a49c80 */ /* readable add is: 0x7f4776a49c80 */ /* Reaable1: Fri Aug 7 06:57:19 2015 */ /* */ /* Reaable2: Fri Aug 7 06:57:19 2015 */ /**************************************************/

- 也就是说ctime是"不可重入"的.新的可重入的ctime()版本是ctime_r()

Converting Between time_t and Broken-Down Time

- 还可以把time_t转化成broken-down time, 所谓broken-down time其实就是把这个时

间分成详细的时间,broken-down time如下

struct tm { int tm_sec; int tm_min; int tm_hour; int tm_mday; int tm_mon; int tm_year; int tm_wday; int tm_yday; int tm_isdst; };

- 转化函数有两个

#include <time.h> struct tm *gmtime(const time_t *timep); struct tm *localtime(const time_t *timep); /* Both return a pointer to a statically allocated */ /* broken-down time structure on success, or NULL on error */

Timezones

- timezone非常的多,而且善变,所以不适合写到库里,而是保存在文件里面,在文件夹

/usr/share/zoneinfo/下面

vagrant@vagrant:~$ ls /usr/share/zoneinfo/ Africa Chile Factory Iceland MET posix UCT America CST6CDT GB Indian Mexico posixrules Universal Antarctica Cuba GB-Eire Iran MST PRC US Arctic EET GMT iso3166.tab MST7MDT PST8PDT UTC Asia Egypt GMT0 Israel Navajo right WET Atlantic Eire GMT-0 Jamaica NZ ROC W-SU Australia EST GMT+0 Japan NZ-CHAT ROK zone.tab Brazil EST5EDT Greenwich Kwajalein Pacific Singapore Zulu Canada Etc Hongkong Libya Poland SystemV CET Europe HST localtime Portugal Turkey

- 比如我们的上海的timezone信息为

vagrant@vagrant:~$ ls -al /usr/share/zoneinfo/Asia/Shanghai lrwxrwxrwx 1 root root 6 Jun 25 13:24 /usr/share/zoneinfo/Asia/Shanghai -> ../PRC

- 获取本机timezone的函数是tzset(), tzset()首先其实是先查看environment variable TZ

Locales

- locales其实和timezone相似,是在/usr/share/locale

vagrant@vagrant:~$ ls /usr/share/locale aa byn en_CA gez kk ml pl sr@latin ug ace ca en_GB gl km mn ps sr@Latn uk af ca@valencia eo gu kn mr pt sv ur am ce es gv ko ms pt_BR sw uz an chr et haw kok mt ro szl ve ar ckb eu he ku my ru ta vec ary crh fa hi kw nb rw ta_LK vi as cs fa_AF hr ky nds sa te wa ast csb fi ht lb ne sc tg wal az cv fil hu ln nl sd th wo be cy fo hy lo nn se ti xh be@latin da fr ia locale.alias nso shn tig zh_CN bg de fr_CA id lt oc si tk zh_HK bn dv frp is lv om sk tl zh_TW bn_IN dz fur it mg or sl tr zu bo el fy ja mhr os so trv br en ga jv mi pa sq tt bs en_AU gd ka mk pam sr tt@iqtelif

Updating the System Clock

The Software Clock (Jiffies)

Process Time

- process time说的是process从创建开始到现在为止,所使用的CPU时间,kernel把CPU时

间分成两种:

- User CPU time: 在user mode流逝的时间

- System CPU time: 在kernel mode流逝的时间

- 我们可以使用bash里面的time命令来在某个程序运行的时候来查看两个cpu时间各自(以

及一共)用去了多少秒.

vagrant@vagrant:~/tmp$ time ./a.out Done! real 0m3.996s user 0m0.756s sys 0m1.236s

- 其各个时间意义如下

- user就是user cpu time.

- sys就是system cpu time.

- real是指从开始到结束用了多少时间,就是我们这一章最开始讲的real time.而user+sys 的时间其实有可能超过real, 因为会有多个线程同时运行,cpu时间用的多于real time

Chapter 11: System Limits and Options

System Limits

- Unix-like系统总会有些限制,比如文件最大为多少,消息队列有多少个级别等等

- 但是不同的Unix实现总有自己的想法,SUSv3不能强制要求不同实现使用同一种限制,但

是可以给这个限制一个"最低值",这种"最低值"一般都会设置在<limits.h>里面以_POSIX_

开头,然后以_MAX结尾:

- _POSIX_MQ_PRIO_MAX(值为32): SUSv3设置队列的级别最多为32个. 但是Linux认为 这个需要多一点,所以设置了自己的MA_PRIO_MAX为32768

- _POSIX_NAME_MAX(值为14): Linux当然定义了一个更长的文件名长度

Chapter 12: System and Process Information

The /proc File System

- 早期Unix实现如果想知道当前kernel的一些"属性"(atributes),是非常困难的,这些属

性包括:

- 系统有多少的process在运行

- 一共process打开了多少文件

- 有哪些文件被锁,用的锁是哪些

- 系统使用了哪些socket

- 为例这些值,是因为早期Unix系统是使用一些privileged program来进入kernel的memory 来获取这些内存里面的值,从而了解kernel当前的"属性".但是这样做很麻烦,因为你必 须知道kernel的内部存储结构,而且随着内核的升级,你的privileged program也要更改 因为内核的数据结构会升级

- 新的Unix系统(比如Linux)为了让这个过程更加简单,设计了一个叫做/proc的文件系统 这个文件夹下的文件,披露了当前kernel的属性信息,你只需要"读写"这些文件就可以了 解kernel,甚至更改kernel的"属性".

- /proc文件系统是virtual的,它是由kernel在runtime维护的,并不保存到文件系统.

- SUSv3并没有定义/proc系统,下面的介绍只适用于Linux

Obtaining information about a Process: /proc/PID

- 对于每一个process, /proc都提供了/proc/PID的这个文件夹来保存这个process的信 息,其中status是总览.

System Information under /proc

- /proc下面还有很多的"系统级"的参数

Directory Information exposed by files in this directory /proc Various system information /proc/net Status information about networking and sockets /proc/sys/fs Settings related to file systems /proc/sys/kernel Various general kernel settings /proc/sys/net Networking and sockets settings /proc/sys/vm Memory-management settings /proc/sysvipc Information about System V IPC objects

Chapter 13: File I/O Buffering

Kernel Buffering of File I/O: The Buffer Cache

- 我们前面学到过处理disk读写的system call(read(), write()), 但是在实际情况下,

这两个system call并不是去处理disk,而是:

- read(): 从kernel buffer cache读取到user-space buffer

- write(): 把user-space buffer写入到kernel buffer cache

- 下面是一个write()的例子

write(fd, "abc", 3);

- write()是在user space和kernel space拷贝,所以其实就是内存级别的操作,会非常的

快的完成,然后返回.kernel会过"一段时间"才把更改写入到disk. 如果在这"一段时间"

里面,有其他的read()请求,那么kernel就直接把buffer cache里面的内容返回即可,这

样一来:

- 减少了一次disk操作

- 并且read(), write()返回速度明显提升.

- 因为这种buffer cache极大的提高了效率,所以Linux只要有空闲的内存,总是会将它们 改装成buffer cache来提高IO的效率.当然如果当前内存不是很足.kernel会把一部分 的内容先写入disk,从而解放出一部分的buffer cache

- NOTE: 虽然我们buffer cache叫的很欢,但是其实Linux里面已经没有一个数据结构叫

做buffer cache了:

- 在2.2版本以前存在这buffer cache和page cache两个概念.page cache我们说过用 来"映射"process使用的virtual memory的.buffer cache是用来加速IO操作,提升IO 效率的

- 从2.4版本开始, buffer cache不存在了.转而是page cache 起两种作用:即用来"映 射"virtual memory,又用来加速IO

Buffering in the stdio Library

- 再来回顾一下读取和写入的system call 的原型

#include <unistd.h> ssize_t read(int fd, void *buf, size_t count); ssize_t write(int fd, const void *buf, size_t count);

- 我们会发现read(), write()都使用了buf, 而这个buf通常是在user-space里面创建的

automatic变量(也就是在stack上面的变量), 比如下面这个模拟copy的例子. buf[BUF_SIZE]

就是user-space buffer

#include <sys/stat.h> #include <fcntl.h> #include "tlpi_hdr.h" #ifndef BUF_SIZE /* Allow "cc -D" to override definition */ #define BUF_SIZE 1024 #endif int main(int argc, char *argv[]) { int inputFd, outputFd, openFlags; mode_t filePerms; ssize_t numRead; char buf[BUF_SIZE]; if (argc != 3 || strcmp(argv[1], "--help") == 0) usageErr("%s old-file new-file\n", argv[0]); /* Open input and output files */ inputFd = open(argv[1], O_RDONLY); if (inputFd == -1) errExit("opening file %s", argv[1]); openFlags = O_CREAT | O_WRONLY | O_TRUNC; filePerms = S_IRUSR | S_IWUSR | S_IRGRP | S_IWGRP | S_IROTH | S_IWOTH; /* rw-rw-rw- */ outputFd = open(argv[2], openFlags, filePerms); if (outputFd == -1) errExit("opening file %s", argv[2]); /* Transfer data until we encounter end of input or an error */ while ((numRead = read(inputFd, buf, BUF_SIZE)) > 0) if (write(outputFd, buf, numRead) != numRead) fatal("couldn't write whole buffer"); if (numRead == -1) errExit("read"); if (close(inputFd) == -1) errExit("close input"); if (close(outputFd) == -1) errExit("close output"); exit(EXIT_SUCCESS); }

- user-space buffer大小的选择有技巧,可以想到的有如下两个极端:

- BUF_SIZE为1, 那么拷贝1千万bytes就需要调用1千万次system call read&write

- BUF_SIZE为1000, 那么拷贝1千万bytes只需要1万次system call read&write

- 那么显然是后面的这次调用更加的合理,因为:

- 虽然有buffer cache的存在,kernel可以把1千万bytes暂存起来统一进行一次disk操 作

- 但是system call也是非常耗费系统资源的操作,所以我们BUF_SIZE要"尽可能的大" 到system call所用时间比起"搬运1千万bytes到磁盘的操作"已经可以忽略的程度.

Buffering in the stdio Library

- 调用system call的时候,尽可能多的设置buffer size从而减少system call调用次数,

提高调用效率,是一种很常见的手段.library function也会调用system call,所以也会

提高自己的buffr size.

对于stdio来说,它会自己创造一个buffer,等这个buffer满了以后,才去调用read&write system call - 而对一个文件使用何种buffer size是由下面的函数确定的.

#incude <stdio.h> int setvbuf(FILE *stream, char *buf, int mode, size_t size); /* Returns 0 on success, or nonzero on error */

- 来分析一下这个函数:

- 参数buf:

- 这个参数可以是NULL, 如果是NULL的话, stdio library会使用automatic的内存 (也就是stack上面的内存)创建一个buffer,大小可以由参数size指定,也可以忽略 size. SUSv3就是直接忽略size的

- 如果这个参数不为NULL,那么这个参数指向的内存必须是static的,或者是dynamic 的地址(也就是heap上的), 因为stdio要使用这个地址,所以其地址必须明确(automatic 内存可能在函数退出的时候被压出栈). 这段内存的开始地址为buf,长度为size 单位为bytes

- 参数mode:buf确定了以后,并不是每次都把buffer"用尽", 需要看mode是什么:

- _IONBF: 如果是这个参数,那么buffer不会被使用.每一个stdio library call 之 后就立刻调用read&write() system call(当然了kernel还是会使用buffer cache 进行一下等待的, 这里讨论的是stdio的二次缓冲buffer), stderr就是使用这种 方式,所以可以尽可能快的打印错误

- _IOLBF: 要么是stdio的buffer满了,要么是遇到了换行,两者满足其一就会返回.

- _IOFBF: 只有stdio的buffer满了,才会调用read&write system call

- 参数buf:

- 当然了,我们也可以在任何时候,把当前的buffer里面的内容flush给read&write system call(请注意区别,我们只能强制library function去调用system call, 但是我们不能 强制kernel什么时候进行disk操作)

- flush buffer内容到read&write system call的函数是

#incude <stdio.h> int fflush(FILE *stream); /* Returns 0 on success, EOF on error */

- 如果stream是NULL的话fflush()会flush所有的stdiio buffer

- 当某个stdio buffer对应的stream关闭的时候,会自动进行一次flush

Controlling Kernel Buffering of File I/O

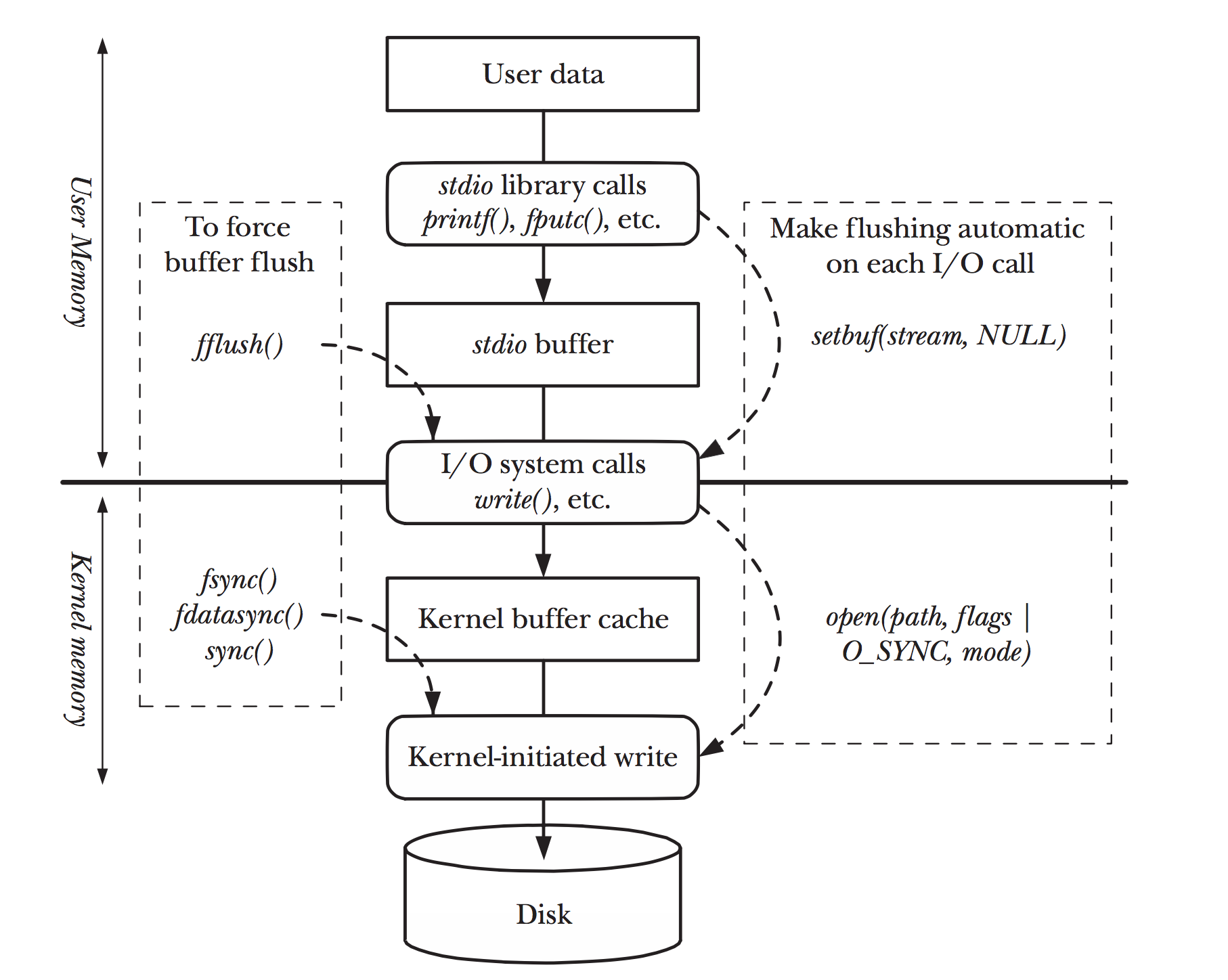

- 前面我们将的fflush其实是"flush user buffer的内容到kernel buffer", 而具体kernel 什么时候把自己的内容flush到disk上,则是我们下面要讨论的内容(不是fflush()能做的到的!)

- 如果一个app需要确认我们的内容已经真正的写入到了disk(而不是只是传给kernel),那 么我们需要force flush kernel buffer

Synchronized I/O data integrity and synchronized I/O file integrity

- SUSv3把kernel的内容是否写入到disk,设计了两类的synchronized I/O completion:

- synchronized I/O data integrity completion: 简言之,就是不影响后续的读取

和写入.:

- synchronized I/O的读取: 一定会确认pending的write都进行完,才读取,而且 (函数返回时)一定是从硬盘读取的.

- synchronized I/O的写入: (函数返回时)一定是写入了disk, 并且相应的meta data也已经都写入disk.

- synchronized I/O file integrity completion: 是上面synchronized I/O data integrity completion的超集,不仅仅不影响读取和写入,而且要求全部的meta信 息都完全准备好了.比如文件的大小会影响下次的写入,但是文件的timestamp却不 会影响.所以文件大小是data integrity level的,而timestamp则是file integrity level的

- synchronized I/O data integrity completion: 简言之,就是不影响后续的读取

和写入.:

System calls for controlling kernel buffering of file I/O

- data integrity completion state级别的flush to disk

#include <unistd.h> int fdatasync(int fd); /* Returns 0 on success, or –1 on error */

- file integrity completion state级别的flush to disk

#include <unistd.h> int fsync(int fd); /* Returns 0 on success, or –1 on error */

Make all write synchronous: O_SYNC

- 当我们open一个文件的时候,如果设置了O_SYNC flag(如下),那么所有对此文件的write()

都是自动的flush kernel buffer到disk的.所以会明显的影响性能!

fd = open(pathname, O_WRONLY | O_SYNC);

- 下面就是我们对flush的一个总结,注意flush的两层意思:'从user buffer到kernel buffer'

和'从kernel buffer 到disk'

Figure 4: two-flush.png

Chapter 14: File System

Device Special Files(Devices)

- 系统中的device都会对应一些"特殊"的文件叫做device special file

- 在kernel内部,每一类文件才会有一个device driver. 所谓device driver是指的kernel 内部一段"专门处理设备input output"的代码

- device driver处理input output的结果是: 在外看来所有的文件都是一样的拥有相应 的system call: open(), close(), read(), write()

- device可以被分成两个类型:

- character device: 以一个character为单位来处理, terminal和键盘是常见的character device

- block device: 以block为单位(通常位512 byte)来处理, disk和tape是常见的block device

- device在文件系统里面的表示就是device file,他们都再/dev文件夹下面. system call 是super user用来创建/dev下面的device file的命令

- 早起版本中, /dev下面包含了系统所有可能的device, 即便这个device根本没有连接 到系统. udev命令可以很好的解决这个问题,找到真正连接且在使用的设备

- 每一个device file都有一个major ID和一个minor ID:

- major用来确定device file类型

- minor用来确定specific device

- 使用ls -l会列出device file的major和minor id

- device file的major id和minor id其实是存在i-node里面的

- device的名字并不重要,kernel只需要通过major和minor id就可以确定了.

Disks and Partitions

- regular files 和 directory一般都是存在hard disk里面的(当然还会有存在CD, flash memory card的文件).

- hard disk的学名叫做HDD (Hard Disk Drive)是一种机械类的设备,有多个platter(盘 片)组成.

- read/write head是负责读取"存储在platter表面的信息", 而这些信息最小的读取和写 入的单位是512bytes

- 虽然现在硬盘的速度很快,但它毕竟是一个机械动作,其一次读取的时间单位为毫秒级别, 而cpu可以在一毫秒的时间内做百万次的操作.

- 一块硬盘通常会分成多个partition,而每一个partition都在/dev下面被看成是一个独 立的device.

- 我们可以通过fdisk -l来查看机器上面的分区情况

vagrant@ ~ $ sudo fdisk -l Disk /dev/sda: 40 GiB, 42949672960 bytes, 83886080 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x00034370 Device Boot Start End Sectors Size Id Type /dev/sda1 * 2048 83886079 83884032 40G 83 Linux

- 而linux特有的/proc/partitions其实里面就特别详细的记录了这些信息

vagrant@ ~ $ cat /proc/partitions major minor #blocks name 8 0 41943040 sda 8 1 41942016 sda1

- disk partition通常有三种类型:

- file system: 保持regular file, directory的常见"文件"系统

- data area: 数据库会使用的,保持raw-mode的设备

- swap area: kernel 管理memory的时候,会用到.

File Systems

- file system是指用来组织regulaer files和directory的, 可以使用mkfs来创建一个文件系统

- Linux的强项是它支持很广泛的文件系统, 比如:

- ext2

- Unix文件系统,Minix, SystemV, BSD file system

- Microsofts' FAT, FAT32, NTFS

- ISO 9660 CD-ROM file system

- Apple Macintosh's HFS

- 一系列的journaling files system: 包括ext3, ext4, JFS, XFS, Btrfs

- ext2 file system在很多年间都是Linux默认的文件系统,其是最早的Linux文件系统ext 的继承者

- 文件系统里面的最小"allocate"单位叫做logical bolck

- logical block通常是多个连续的physical block, physical block通常为512bytes(这 是因为历史上,一个sector的大小是512Bytes, 虽然最近disk已经有比较大的sector,比 如4096bytes,但是为了兼容性, hard disk还是会通过一些设置让操作系统看起来自己 依然是512bytes一个block, 而使用这种技术的hard disk会把512叫做hardware logic block size, 而把4096叫做hardware physical bloack size非常有趣)所以logical block在ext2上面通常是1024, 2048或者4096bytes

- 下图简单描述了disk partition和file system的关系

+------------------+-----------------------------+---------------+ Disk | partition | partition | partition | | + | | +------------------/-----------------------------\---------------+ / \ / \ / \ / \ / \ / \ / \ / \ +-----+-----+------+----------------------------+ |boot |super|i-node| data blocks | File System |block|block|table | | +-----+-----+------+----------------------------+ - 上图各个部分的说明如下:

- boot block: 这永远都会是file system的第一个block. boot block是不会被file system所使用的.但是它却包含了如何启动操作系统的信息.虽然操作系统只需要一个 boot block.但是所有的file system都保留了一个boot block(大部分都没有使用)

- superblock: 是单独的一个block, 紧接着boot block, 包含了如下的数据:

- i-node table的大小

- 每一个logical block的大小

- 有多少的logical block

- i-node table: 每一个文件或者文件夹又在i-node里面对应了一个entry

- data blocks: 大部分的file system就是data blocks,用来存储文件和文件夹.

I-nodes

- i-node table为每一个当前partition的文件或者文件夹都准备了一个entry,而且这个

entry是有序列号的.使用ls -li就可以得到这个序列号

vagrant@ testCode (master) $ ls -li total 12 1244565 -rw-rw-r-- 1 vagrant vagrant 182 Aug 12 18:57 README.md 1731792 drwxrwxr-x 3 vagrant vagrant 4096 Aug 12 18:57 daily 1731796 drwxrwxr-x 4 vagrant vagrant 4096 Aug 12 18:57 prev

- i-node里面包含了很多的信息,包括:

- file type: regular file, directory, symbolic link, character device

- Owner for the file

- Group for the file

- Access permissions for owner, group, and other. 需要注意的是root通常被认

为是拥有一切的权限.所以一个不能运行的hello.c在root看来也是rwx的,只不过在

执行的时候,会出现command not found错误而已.

vagrant@ tmp $ ls -al hello.c -rw-rw-r-- 1 vagrant vagrant 167 Aug 16 19:39 hello.c vagrant@ tmp $ ./hello.c bash: ./hello.c: Permission denied vagrant@ tmp $ sudo ./hello.c sudo: ./hello.c: command not found

- 三个时间戳

- time of last access to the file (ls -lu: 打开文件的操作,不一定要改动)

- time of last modification of the file(ls -l: 上次改动文件的操作的时间)

- time of last status change(ls -lc: 上次改动i-node的时间: 改动文件内容 "一定"改动i-node.但是改动i-node"不一定"改动文件内容)

- 指向文件的hard link的数目

- 文件以byte记的大小